C'est un des thèmes préférés de Eric Schmidt, actuellement "Executive Chairman" de Google. Une des premières citations de Eric Schimdt autour de ce thème semble dater de août 2010, dans une interview réalisée par le Wall Street Journal, Google and the search for the future

Les déclinaisons ont été nombreuses, aussi bien lors des interviews données par Eric Schmidt qu'à l'occasion de ses conférences.

Mais l'ensemble des assertions prononcées alors se rejoignent dans la même direction : Google sait tout, et à l'aune du Big Data, Google en est le meilleur exemple. Avec tous les travers que cela pourrait représenter dans le futur.

- Nous savons où vous êtes

- Nous savons où vous êtes allé

- Nous savons qui sont vos amis

- Nous savons avec qui vous êtes

- Nous savons ce que vous pensez

...

Lors de la conférence proposée par GS1 sur le Big Data il y a quelques semaines, Christophe Benavent a défendu une thèse opposée. Il estime en effet que le morcellement de notre identité numérique ne permet à aucun collecteur de données de réellement savoir qui chacun de nous est. Nous ne donnerions à chacun qu'une facette de notre personnalité.

A réfléchir...

Les déclinaisons ont été nombreuses, aussi bien lors des interviews données par Eric Schmidt qu'à l'occasion de ses conférences.

Mais l'ensemble des assertions prononcées alors se rejoignent dans la même direction : Google sait tout, et à l'aune du Big Data, Google en est le meilleur exemple. Avec tous les travers que cela pourrait représenter dans le futur.

- Nous savons où vous êtes

- Nous savons où vous êtes allé

- Nous savons qui sont vos amis

- Nous savons avec qui vous êtes

- Nous savons ce que vous pensez

...

Lors de la conférence proposée par GS1 sur le Big Data il y a quelques semaines, Christophe Benavent a défendu une thèse opposée. Il estime en effet que le morcellement de notre identité numérique ne permet à aucun collecteur de données de réellement savoir qui chacun de nous est. Nous ne donnerions à chacun qu'une facette de notre personnalité.

A réfléchir...

Par Philippe Nieuwbourg le Samedi 15 Septembre 2012

|

0 commentaire

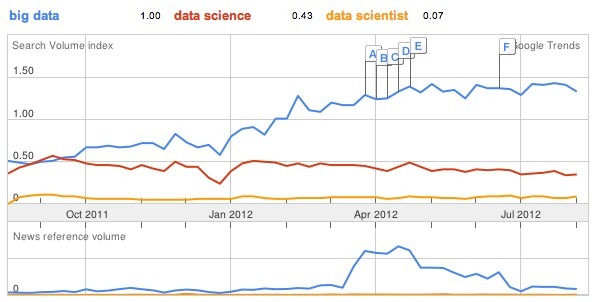

C'est ce que nous apprend le graphique comparatif réalisé avec Google Trends, comparant l'usage des termes "Big Data", "Data Science" et "Data Scientist".

Alors que le nombre de requêtes correspondant au terme de "data science" reste stable, et baisse même un peu ces derniers mois, l'engouement et les interrogation sur le big data progressent.

Sur les douze derniers mois, le nombre de requêtes concernant le terme "big data" dans Google a presque triplé.

En parallèle, il faut noter une progression importante du nombre d'articles référencés par Google traitant du big data pendant le 2ème trimestre 2012. La période d'été semble avoir été beaucoup plus calme, mais Google fournit des chiffres bruts, non "corrigés des variations saisonnières". Il sera donc intéressant de reprendre la même analyse dans quelques mois pour vérifier ou corriger cette tendance.

Sur les douze derniers mois, le nombre de requêtes concernant le terme "big data" dans Google a presque triplé.

En parallèle, il faut noter une progression importante du nombre d'articles référencés par Google traitant du big data pendant le 2ème trimestre 2012. La période d'été semble avoir été beaucoup plus calme, mais Google fournit des chiffres bruts, non "corrigés des variations saisonnières". Il sera donc intéressant de reprendre la même analyse dans quelques mois pour vérifier ou corriger cette tendance.

Le titre est évidemment un peu provocateur. Mais après avoir plusieurs fois échangé avec les organisateurs de Big Data Europe, une conférence européenne itinérante, je constate que la France ne fait plus partie des pays ciblés. L'événement prévu en France a été annulé.

La conference Big Data Europe s'arrêtera en effet en Suisse, Autriche, Allemagne, Suède, Pologne et Turquie. Mais les pays du sud sont tous absents de cette tournée !

Pourquoi ?

Selon l'organisateur, IIR technology, une division de Euroforum, "la situation économique semble beaucoup affecter les filiales françaises des entreprises des nouvelles technologies, nous n'avons pas pu convaincre suffisamment de sponsors et engager suffisamment de conférenciers. Peut-être pourrons-nous essayer de nouveau en 2013, quand la situation se sera améliorée".

Autre absent de ce circuit, l'Angleterre. Mais la raison semble complètement inverse, et c'est au contraire le nombre de conférences déjà en cours d'organisation sur le Big Data outre-manche qui a conduit Euroforum à délaisser ce pays.

Les principaux sponsors de cette conférence sont pourtant des sociétés bien connues en France : EMC, IBM, Teradata et même Capgemini ! Mais il semble que le marché français ne soit donc plus une priorité pour ces fournisseurs de technologies.

La France serait-elle donc dans la même situation que la Grèce, l'Italie et l'Espagne du point de vue de la réflexion autour des opportunités du Big Data ? Qu'en pensez-vous ?

La conference Big Data Europe s'arrêtera en effet en Suisse, Autriche, Allemagne, Suède, Pologne et Turquie. Mais les pays du sud sont tous absents de cette tournée !

Pourquoi ?

Selon l'organisateur, IIR technology, une division de Euroforum, "la situation économique semble beaucoup affecter les filiales françaises des entreprises des nouvelles technologies, nous n'avons pas pu convaincre suffisamment de sponsors et engager suffisamment de conférenciers. Peut-être pourrons-nous essayer de nouveau en 2013, quand la situation se sera améliorée".

Autre absent de ce circuit, l'Angleterre. Mais la raison semble complètement inverse, et c'est au contraire le nombre de conférences déjà en cours d'organisation sur le Big Data outre-manche qui a conduit Euroforum à délaisser ce pays.

Les principaux sponsors de cette conférence sont pourtant des sociétés bien connues en France : EMC, IBM, Teradata et même Capgemini ! Mais il semble que le marché français ne soit donc plus une priorité pour ces fournisseurs de technologies.

La France serait-elle donc dans la même situation que la Grèce, l'Italie et l'Espagne du point de vue de la réflexion autour des opportunités du Big Data ? Qu'en pensez-vous ?

Go Big... or Go Home!

La multinationale réunissait la semaine dernière au "Magic Kingdom", pardon au centre de conférences Disney à Orlando, les principaux représentants de l'entreprise intéressés par le Big Data et l'analyse de données.

Un sommet interne, sur deux jours, où les meilleurs spécialistes des éditeurs conviés se sont pressés afin de démontrer leurs technologies à ce grand acheteur potentiel.

Partager les meilleures pratiques, découvrir de nouvelles solutions pour résoudre des problèmes complexes, analyser les tendances en matière de prévisions et de politiques de prix… les sujets proposés étaient nombreux.

Du côté des éditeurs de logiciels, SAS, IBM, Roambi, Teradata, Greenplum, Adobe… faisaient partie des invités.

J'ai bien aimé le titre de la présentation de SAS : "Go Big… or Go Home!"

Vous pouvez consulter le programme détaillé de cet événement (tant que Disney le laisse en ligne) sur : http://www.disneynow.com/profile/web/index.cfm?PKwebID=0x31047566f&varPage=home

Je pense que l'organisation d'une telle conférence interne sur les sujets de l'analyse de données, du big data, et des opportunités qui s'en dégagent, est un signal fort de l'intérêt que portent les grandes entreprises américaines à ce phénomène.

L'exemple de Disney est à suivre. A quand un sommet interne de ce type en France chez Total, Sanofi, LVMH, BNP Paribas ou Air Liquide (pour ne prendre que les 5 premières pondérations du CAC 40) ? Si vous avez besoin d'aide pour organiser cela, et réfléchir aux opportunités du Big Data au sein de votre groupe… Nous pouvons en parler :-)

Un sommet interne, sur deux jours, où les meilleurs spécialistes des éditeurs conviés se sont pressés afin de démontrer leurs technologies à ce grand acheteur potentiel.

Partager les meilleures pratiques, découvrir de nouvelles solutions pour résoudre des problèmes complexes, analyser les tendances en matière de prévisions et de politiques de prix… les sujets proposés étaient nombreux.

Du côté des éditeurs de logiciels, SAS, IBM, Roambi, Teradata, Greenplum, Adobe… faisaient partie des invités.

J'ai bien aimé le titre de la présentation de SAS : "Go Big… or Go Home!"

Vous pouvez consulter le programme détaillé de cet événement (tant que Disney le laisse en ligne) sur : http://www.disneynow.com/profile/web/index.cfm?PKwebID=0x31047566f&varPage=home

Je pense que l'organisation d'une telle conférence interne sur les sujets de l'analyse de données, du big data, et des opportunités qui s'en dégagent, est un signal fort de l'intérêt que portent les grandes entreprises américaines à ce phénomène.

L'exemple de Disney est à suivre. A quand un sommet interne de ce type en France chez Total, Sanofi, LVMH, BNP Paribas ou Air Liquide (pour ne prendre que les 5 premières pondérations du CAC 40) ? Si vous avez besoin d'aide pour organiser cela, et réfléchir aux opportunités du Big Data au sein de votre groupe… Nous pouvons en parler :-)

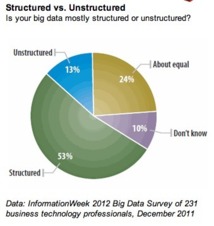

L'étude date un peu (décembre 2011), publiée par InformationWeek. Mais elle donne un point de départ.

En décembre 2011, 53 % des personnes interrogées (attention, 231 répondants seulement) indiquaient que leur "big data" étaient essentiellement composées de données structurées. Tout le monde n'est en effet pas encore passé à l'analyse des véritables données non structurées. Même les plus grands comme Facebook, Twitter, Google, analysent essentiellement des données structurées, même s'ils stockent et manipulent également de gros volumes de données non structurées.

Prenons l'exemple de Facebook, collecter une image chargée par un utilisateur consiste juste à manipuler un fichier image, pas la peine de chercher à le "comprendre". Il ne s'agit là que de données structurées associées à un fichier image.

Mais lorsque Facebook se lance dans la reconnaissance de visages, là, on passe à l'analyse de données non structurées.

Même chose avec un statut. Le stocker dans une base de données n'est pas compliqué. C'est juste un champ texte et des méta-données. Mais tenter d'en analyser le contenu pour "comprendre" ce que l'utilisateur a voulu dire, c'est autre chose.

Face à l'absence de définition claire des périmètres, les répondants aux sondages ont alors tendance à répondre "ce qui les met en valeur". D'où les résultats de cette enquête qui fait ressortir que 13 % des personnes interrogées ont un entrepôt de données composé essentiellement de données non structurées, et 24 % où la répartition structurées / non structurées est équitable. Ce qui me semble énorme, et complètement déconnecté de la réalité des entreprises que je rencontre.

Sauf si tous les champs "texte" comme une adresse, un nom, un commentaire.. sont considérés comme "non structuré" ! Facile alors de parvenir à ces chiffres. Mais on n'aura finalement rien appris...

En décembre 2011, 53 % des personnes interrogées (attention, 231 répondants seulement) indiquaient que leur "big data" étaient essentiellement composées de données structurées. Tout le monde n'est en effet pas encore passé à l'analyse des véritables données non structurées. Même les plus grands comme Facebook, Twitter, Google, analysent essentiellement des données structurées, même s'ils stockent et manipulent également de gros volumes de données non structurées.

Prenons l'exemple de Facebook, collecter une image chargée par un utilisateur consiste juste à manipuler un fichier image, pas la peine de chercher à le "comprendre". Il ne s'agit là que de données structurées associées à un fichier image.

Mais lorsque Facebook se lance dans la reconnaissance de visages, là, on passe à l'analyse de données non structurées.

Même chose avec un statut. Le stocker dans une base de données n'est pas compliqué. C'est juste un champ texte et des méta-données. Mais tenter d'en analyser le contenu pour "comprendre" ce que l'utilisateur a voulu dire, c'est autre chose.

Face à l'absence de définition claire des périmètres, les répondants aux sondages ont alors tendance à répondre "ce qui les met en valeur". D'où les résultats de cette enquête qui fait ressortir que 13 % des personnes interrogées ont un entrepôt de données composé essentiellement de données non structurées, et 24 % où la répartition structurées / non structurées est équitable. Ce qui me semble énorme, et complètement déconnecté de la réalité des entreprises que je rencontre.

Sauf si tous les champs "texte" comme une adresse, un nom, un commentaire.. sont considérés comme "non structuré" ! Facile alors de parvenir à ces chiffres. Mais on n'aura finalement rien appris...

Quelques chiffres révélés par Facebook lors d'une conférence de presse et publiés par TechCrunch.

Des chiffres "Big Data" qui se passent de commentaires…

Chaque jour :

- 2,5 milliards d'objets traités

- 500 To de nouvelles données traitées

- 2,7 milliards de "like"

- 300 millions de photos intégrées

- 70 000 requêtes

et… 210 To de données Hadoop (via Hive) manipulées… chaque heure !

En stock :

- 100 Po de données sur une seule grappe Hadoop

Les mauvais esprits ajouteront un chiffre :

- Cours de bourse : -31 % en un mois de cotation… celui-ci aussi sans commentaire…

Des chiffres "Big Data" qui se passent de commentaires…

Chaque jour :

- 2,5 milliards d'objets traités

- 500 To de nouvelles données traitées

- 2,7 milliards de "like"

- 300 millions de photos intégrées

- 70 000 requêtes

et… 210 To de données Hadoop (via Hive) manipulées… chaque heure !

En stock :

- 100 Po de données sur une seule grappe Hadoop

Les mauvais esprits ajouteront un chiffre :

- Cours de bourse : -31 % en un mois de cotation… celui-ci aussi sans commentaire…

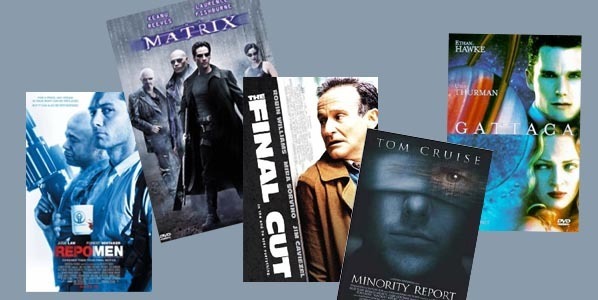

Les scénaristes et réalisateurs de films ont toujours été en avance, tout comme les auteurs de romans de science-fiction, sur les technologies. Son imagination sans limite a permis à Jules Verne d'imaginer la conquête spatiale, les sous-marins, la spéléologie, etc.

Plus proche de nous, les films d'anticipation sont une bonne source de réflexion sur le sujet du Big Data. La question n'est pas de savoir si dans le futur nous porterons des combinaisons argentées et nous nourrirons de pilules, mais de prolonger la réalité pour imaginer ce qu'elle sera demain, tout en la gardant plausible.

Et en matière de Big Data, nous sommes servis ! Même si le sujet et les architectures techniques ne sont presque jamais directement évoqués dans ces films, plusieurs films d'anticipation nous racontent comment les données influenceront notre vie, dans quelques années ou décennies. Dans le cadre de la rédaction de mon livre, je me suis donc plié à de longues séances de visionnage.

Afin de couper court à toute remarque ironique de certains d'entre vous, oui, c'est une facette intéressante du travail de recherche; mais non, ce n'est pas toujours une partie de plaisir.

D'abord parce que tous les films ne sont pas des chef-d'oeuvres. Certains ont un peu vieilli, comme Bienvenue à Gattaca qui manque cruellement de rythme. Et pour tous, regarder un film avec à portée de main un bloc et un crayon, pour noter idées et citations en temps réel, ainsi que leur position exacte dans le film, ne permet pas véritablement de plonger dans l'intrigue. Mais je ne me plains pas !

D'abord parce que j'admire le processus créatif des auteurs. Je repense souvent à Minority Report qui en 2002, il y a dix ans, nous parlait d'analyse prédictive, d'interfaces naturelles, etc. Les deux sont devenues réalités : Microsoft Kinect nous permet de jouer à Minority Report dans notre salon. Quant à SAS et SPSS, ils ont été retenus par plusieurs services de police qui prépositionnent aujourd'hui leurs effectifs là où un crime va, statistiquement, se produire.

Alors quels films illustrent le mieux l'avenir du Big Data et son impact sur notre vie quotidienne ?

Voici les films que j'ai sélectionné :

- Minority Report : on y parle d'analyse prédictive, d'anticipation des événements, etc. et même si les données proviennent en 2054 du cerveau des extra-lucides installés au ministère de la justice et non d'un ordinateur, la réflexion sur la prédictibilité des événements et la prise de décision est intéressante.

- Matrix : la matrice est sans doute le meilleur exemple de Big Data de l'histoire du cinéma.

- The Final Cut : votre vie est enregistrée sous forme de vidéo, des centaines de milliers d'heures qui gardent en mémoire toute votre existence. A votre mort, des monteurs transforment cela en un film mémoriel afin que le meilleur soit conservé et le pire oublié. Du point de vue technologique, nous ne sommes plus très loin d'en être capable.

- Repo Men : Lors d'un accident de santé, on vous implante sans votre consentement, un organe artificiel que vous devez ensuite payer chaque mois. Si vous n'en avez plus les moyens, la société vient vous le reprendre ! Moins directement en rapport avec le big data, le film est néanmoins rempli de références technologies intéressantes.

- Gattaca : dans le monde de Gattaca, le séquençage de l'ADN se fait à la naissance, instantanément, et sert d'identification numérique tout au long de votre vie. Vos risques sont mesurés dès la naissance, et pour espérer un avenir, vous devez faire partie de l'élite. Mon rendez-vous avec Philippe Hupé de l'Institut Curie, m'a confirmé là encore que nous nous approchons petit à petit de la capacité technologique à faire de Gattaca un monde possible… mais pas souhaitable bien sur.

Avez-vous d'autres suggestions de films qui nous racontent une histoire du Big Data ? N'hésitez pas à utiliser les commentaires ci-dessous pour me faire part de vos suggestions.

Je cherche en particulier le titre d'un film dont je n'ai que quelques souvenirs : on y parle d'assurances maladies qui ne vous prennent en charge que si vous respectez certains engagements (ne pas fumer, manger sain…); chaque matin une analyse d'urine confirme si l'assureur accepte toujours de vous couvrir. Le héros conserve des flacons de ses jours sobres et tente de tromper le détecteur. Malheureusement il a un accident; les tests sont refaits à l'hôpital et l'assureur annule sa prise en charge… Quelqu'un peut-il m'aider à retrouver ce film ?

Afin de couper court à toute remarque ironique de certains d'entre vous, oui, c'est une facette intéressante du travail de recherche; mais non, ce n'est pas toujours une partie de plaisir.

D'abord parce que tous les films ne sont pas des chef-d'oeuvres. Certains ont un peu vieilli, comme Bienvenue à Gattaca qui manque cruellement de rythme. Et pour tous, regarder un film avec à portée de main un bloc et un crayon, pour noter idées et citations en temps réel, ainsi que leur position exacte dans le film, ne permet pas véritablement de plonger dans l'intrigue. Mais je ne me plains pas !

D'abord parce que j'admire le processus créatif des auteurs. Je repense souvent à Minority Report qui en 2002, il y a dix ans, nous parlait d'analyse prédictive, d'interfaces naturelles, etc. Les deux sont devenues réalités : Microsoft Kinect nous permet de jouer à Minority Report dans notre salon. Quant à SAS et SPSS, ils ont été retenus par plusieurs services de police qui prépositionnent aujourd'hui leurs effectifs là où un crime va, statistiquement, se produire.

Alors quels films illustrent le mieux l'avenir du Big Data et son impact sur notre vie quotidienne ?

Voici les films que j'ai sélectionné :

- Minority Report : on y parle d'analyse prédictive, d'anticipation des événements, etc. et même si les données proviennent en 2054 du cerveau des extra-lucides installés au ministère de la justice et non d'un ordinateur, la réflexion sur la prédictibilité des événements et la prise de décision est intéressante.

- Matrix : la matrice est sans doute le meilleur exemple de Big Data de l'histoire du cinéma.

- The Final Cut : votre vie est enregistrée sous forme de vidéo, des centaines de milliers d'heures qui gardent en mémoire toute votre existence. A votre mort, des monteurs transforment cela en un film mémoriel afin que le meilleur soit conservé et le pire oublié. Du point de vue technologique, nous ne sommes plus très loin d'en être capable.

- Repo Men : Lors d'un accident de santé, on vous implante sans votre consentement, un organe artificiel que vous devez ensuite payer chaque mois. Si vous n'en avez plus les moyens, la société vient vous le reprendre ! Moins directement en rapport avec le big data, le film est néanmoins rempli de références technologies intéressantes.

- Gattaca : dans le monde de Gattaca, le séquençage de l'ADN se fait à la naissance, instantanément, et sert d'identification numérique tout au long de votre vie. Vos risques sont mesurés dès la naissance, et pour espérer un avenir, vous devez faire partie de l'élite. Mon rendez-vous avec Philippe Hupé de l'Institut Curie, m'a confirmé là encore que nous nous approchons petit à petit de la capacité technologique à faire de Gattaca un monde possible… mais pas souhaitable bien sur.

Avez-vous d'autres suggestions de films qui nous racontent une histoire du Big Data ? N'hésitez pas à utiliser les commentaires ci-dessous pour me faire part de vos suggestions.

Je cherche en particulier le titre d'un film dont je n'ai que quelques souvenirs : on y parle d'assurances maladies qui ne vous prennent en charge que si vous respectez certains engagements (ne pas fumer, manger sain…); chaque matin une analyse d'urine confirme si l'assureur accepte toujours de vous couvrir. Le héros conserve des flacons de ses jours sobres et tente de tromper le détecteur. Malheureusement il a un accident; les tests sont refaits à l'hôpital et l'assureur annule sa prise en charge… Quelqu'un peut-il m'aider à retrouver ce film ?

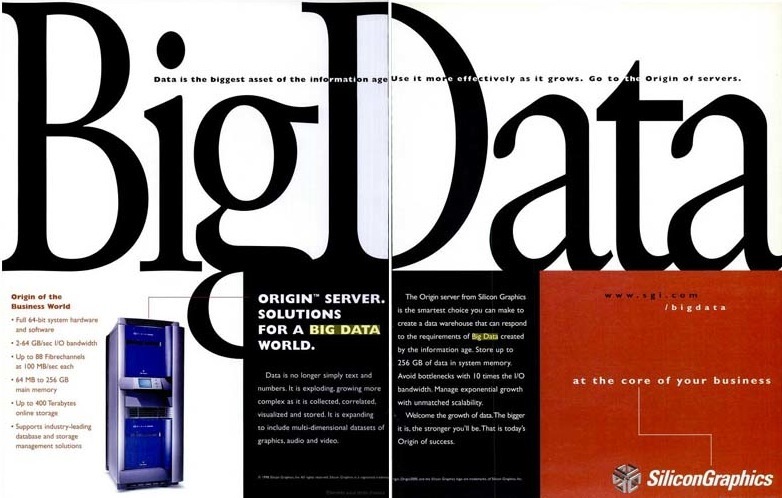

Vous pensiez que le Big Data était une invention récente; un mot-clef marketing imaginé dans la Silicon Valley ces deux dernières années pour faire vendre plus de machines, plus de logiciels… et bien pas du tout !

D'après mes recherches, la première société informatique à avoir véritablement exploité et publicisé ce concept de Big Data est Silicon Graphics. Et nous sommes en 1997, le 17 novembre, le terme Big Data apparait dans une publicité pour sa gamme de serveurs "Origin" dans le magazine InfoWorld [Silicon Graphics. (1997, November 17). Publicité Silicon Graphics. InfoWorld, 19(46), 30]. Et quelques mois plus tard, c'est toute la publicité pour ce serveur qui bénéficie du slogan de "Big Data". Le 2 mars 1998 dans une autre publicité, le discours est clairement semblable à celui que nous relayons aujourd'hui. Extrait : "Data is no longer simply text and numbers. It is exploding, growing more complex as it is collected, correlated, visualized and stored. It is expanding to include multi-dimensional datasets of graphics, audio and video.

The Origin Server from Silicon Graphics is the smartest choice you can make to create a data warehouse that can respond to the requirements of Big Data created by the information age. Store up to 256 Gb of data in a system memory. Avoid bottlenecks with 10 times the I/O bandwith. Manage exponential growth with unmatched scalability. Welcome the growth of data. The bigger it is the stronger you'll be. That is today's Origin of success". [Silicon Graphics. (1998, March 2). Publicité Silicon Graphics. InfoWorld, 20(9), 52].

Et même le site web de Silicon Graphics est de la partie puisqu'une URL dédiée est créée http://www.sgi.com/bigdata. Elle n'est plus active aujourd'hui… dommage.

Comme je l'avais écrit dans Decideo, une présentation de John Mashey, alors "Chief Scienstist" chez SGI confirme l'intérêt que portait l'entreprise à ce concept. John Mashey vient d'ailleurs de me le confirmer directement par email : "Je faisais tout mon possible pour que la gestion des données et des entrées/sorties soit une des priorités chez SGI. Nous avons fabriqué des ordinateurs avec de fantastiques entrées/sorties et des systèmes de gestion de gros fichiers, mais parfois nous ne les avons pas promus comme ils auraient du l'être". John Mashey refuse avec modestie de s'attribuer l'invention du terme "big data", mais il reconnait qu'il "a certainement fait plus que presque tout autre chez SGI pour évangéliser" le "Big Data".

The Origin Server from Silicon Graphics is the smartest choice you can make to create a data warehouse that can respond to the requirements of Big Data created by the information age. Store up to 256 Gb of data in a system memory. Avoid bottlenecks with 10 times the I/O bandwith. Manage exponential growth with unmatched scalability. Welcome the growth of data. The bigger it is the stronger you'll be. That is today's Origin of success". [Silicon Graphics. (1998, March 2). Publicité Silicon Graphics. InfoWorld, 20(9), 52].

Et même le site web de Silicon Graphics est de la partie puisqu'une URL dédiée est créée http://www.sgi.com/bigdata. Elle n'est plus active aujourd'hui… dommage.

Comme je l'avais écrit dans Decideo, une présentation de John Mashey, alors "Chief Scienstist" chez SGI confirme l'intérêt que portait l'entreprise à ce concept. John Mashey vient d'ailleurs de me le confirmer directement par email : "Je faisais tout mon possible pour que la gestion des données et des entrées/sorties soit une des priorités chez SGI. Nous avons fabriqué des ordinateurs avec de fantastiques entrées/sorties et des systèmes de gestion de gros fichiers, mais parfois nous ne les avons pas promus comme ils auraient du l'être". John Mashey refuse avec modestie de s'attribuer l'invention du terme "big data", mais il reconnait qu'il "a certainement fait plus que presque tout autre chez SGI pour évangéliser" le "Big Data".

Encore une histoire d'outils aujourd'hui. Car la rédaction d'un livre nécessite beaucoup de manipulation de données : citations, interviews, références, etc. Hors de question bien sur de m'approprier un contenu dont je ne sois pas l'auteur. Et comme j'ambitionne que ce premier livre en français sur le big data soit également préconisé par certains enseignants, je me dois d'être rigoureux sur le sujet. Sans doute la fréquentation depuis un an de mes amis et collègues de l'UQAM y est-elle pour quelque chose… moi qui n'avait jamais mis les pieds à l'université avant d'y enseigner, je découvre certaines pratiques, et je les apprends sur le tas.

Citations, références, bibliographie… donc, voici mon sujet du jour. Alors bien sur, il est possible de gérer tout cela manuellement, ou dans un simple traitement de texte. Mais sur 250 pages de texte, je devrais bien arriver à 200 ou 300 références… et comme tout geek qui se respecte, face à un problème, je me fais plaisir en cherchant un outil :-)

Scrivener que je vous ai décrit en début de semaine, dispose d'une fonction pour gérer les citations et créer ainsi les notes de bas de page avec les références complètes de ce que vous citez.

Mais un paramètre qui permet de lier Scrivener à un éditeur de références externes (Bibliography / citations manager) a attiré mon attention. Je ne connais pas du tout ce domaine. Et me voici plongé dans les forums pour découvrir ce marché.

Si vous souhaitez vous-aussi faire le tour des outils, voici deux liens qui vous conduiront directement vers tous les outils du marché :

- http://en.wikipedia.org/wiki/Comparison_of_reference_management_software

- http://www.library.wisc.edu/citation-managers/comparison.html

Après avoir lu tout cela en détail, je comprends que deux outils figurent un peu sur le dessus du panier, Zotero et [EndNote]http://www.endnote.com/. Ils semblent en tous cas les plus cités par les chercheurs et rédacteurs. Ma présélection étant faite, il me faut maintenant comparer ces deux bons logiciels. Je tombe justement sur une excellente comparaison, qui semble objective, sur le site ProfHacker

Ma première impression est confirmée, les deux outils sont très proches et tous deux conviendraient certainement à mon usage de débutant en la matière.

Je choisis finalement Zotero pour plusieurs raisons : il est gratuit (alors que EndNote coute quand même 250 $), son format de données est ouvert et je pourrais facilement transférer ma base de références dans un autre outil si nécessaire, il semble doté de fonctions de synchronisation avancées qui me plaisent car je travaille en permanence sur plusieurs machines. Et pour finir c'est un projet universitaire qui me plait bien, alors que EndNote est édité par Thomson Reuters… qui n'a pas vraiment besoin de mon argent :-)

C'est donc parti pour Zotero, et je vais commencer à l'alimenter avec l'ensemble de mes recherches. Pas certains que je trouverai le temps de tout basculer, mais je vais plutôt l'utiliser au fil de l'eau à partir de maintenant. Et je vous ferai bien sur un retour sur mon expérience.

Et si vous voulez voir cela en vidéo, en quelques minutes, voici le lien : http://www.zotero.org/support/quick_start_guide

Scrivener que je vous ai décrit en début de semaine, dispose d'une fonction pour gérer les citations et créer ainsi les notes de bas de page avec les références complètes de ce que vous citez.

Mais un paramètre qui permet de lier Scrivener à un éditeur de références externes (Bibliography / citations manager) a attiré mon attention. Je ne connais pas du tout ce domaine. Et me voici plongé dans les forums pour découvrir ce marché.

Si vous souhaitez vous-aussi faire le tour des outils, voici deux liens qui vous conduiront directement vers tous les outils du marché :

- http://en.wikipedia.org/wiki/Comparison_of_reference_management_software

- http://www.library.wisc.edu/citation-managers/comparison.html

Après avoir lu tout cela en détail, je comprends que deux outils figurent un peu sur le dessus du panier, Zotero et [EndNote]http://www.endnote.com/. Ils semblent en tous cas les plus cités par les chercheurs et rédacteurs. Ma présélection étant faite, il me faut maintenant comparer ces deux bons logiciels. Je tombe justement sur une excellente comparaison, qui semble objective, sur le site ProfHacker

Ma première impression est confirmée, les deux outils sont très proches et tous deux conviendraient certainement à mon usage de débutant en la matière.

Je choisis finalement Zotero pour plusieurs raisons : il est gratuit (alors que EndNote coute quand même 250 $), son format de données est ouvert et je pourrais facilement transférer ma base de références dans un autre outil si nécessaire, il semble doté de fonctions de synchronisation avancées qui me plaisent car je travaille en permanence sur plusieurs machines. Et pour finir c'est un projet universitaire qui me plait bien, alors que EndNote est édité par Thomson Reuters… qui n'a pas vraiment besoin de mon argent :-)

C'est donc parti pour Zotero, et je vais commencer à l'alimenter avec l'ensemble de mes recherches. Pas certains que je trouverai le temps de tout basculer, mais je vais plutôt l'utiliser au fil de l'eau à partir de maintenant. Et je vous ferai bien sur un retour sur mon expérience.

Et si vous voulez voir cela en vidéo, en quelques minutes, voici le lien : http://www.zotero.org/support/quick_start_guide

Problème du jour : Comment représenter 1 valeur par minute, pendant les 7 heures quotidiennes d'ouverture des 14 bourses américaines, pendant 5 ans ? et faire en sorte que le graphique fasse passer un message...

Faites le calcul, ce n'est pas du big data ! Juste 10 731 000 valeurs (environ) à représenter.

Rien de bien compliqué... apparemment... car une des facettes du big data que je développerai dans le livre est un "V" supplémentaire, celui de la visualisation.

Si ces données sont le nombre d'opérations automatisées passées sur le marché financier américain, pendant ces cinq dernières années, jour par jour, c'est leur comparaison qui devient intéressante.

Et c'est là que le graphique dynamique parle. En regardant l'animation ci-dessous, vous constaterez comme moi que le volume des transactions automatisées était très raisonnable en 2007 et qu'il a pris ces dernières années des proportions inquiétantes. Certains disent qu'il faut y voir une des raisons de la crise financière et des variations excessives que connaissent les marchés et qui font la joie de Thomas Blar ! Ce n'est pas mon propos ici :-)

Pour représenter des données qui contiennent un axe temporel, il ne faut pas hésiter à utiliser des graphiques dynamiques. Le mouvement représente le temps - la date est d'ailleurs bien indiquée en bas à gauche. Et l'accélération du temps fait prendre conscience du phénomène.

Faut-il des outils complexes et coûteux pour y parvenir ? Pas du tout ! Cette animation est un simple fichier "gif animé", c'est à dire une succession d'images fixes, que le gif animé fait défiler à vitesse rapide. Tout comme la roue de Faraday en 1830, le gif animé joue sur la persistence rétinienne pour faire croire à l'oeil qu'on lui présente un mouvement alors qu'il ne s'agit que d'une suite d'images fixes.

Pas besoin de logiciels couteux et complexes, avec un peu d'imagination, vous pourrez vous aussi animer vos images.

Faire du big data, c'est bien sur collecter, stocker et analyser de grandes quantités de données, mais c'est aussi les représenter sous forme graphique le plus souvent, afin d'en faire comprendre le message à son public. Je crois beaucoup à la force du "V" de la visualisation !

Faites le calcul, ce n'est pas du big data ! Juste 10 731 000 valeurs (environ) à représenter.

Rien de bien compliqué... apparemment... car une des facettes du big data que je développerai dans le livre est un "V" supplémentaire, celui de la visualisation.

Si ces données sont le nombre d'opérations automatisées passées sur le marché financier américain, pendant ces cinq dernières années, jour par jour, c'est leur comparaison qui devient intéressante.

Et c'est là que le graphique dynamique parle. En regardant l'animation ci-dessous, vous constaterez comme moi que le volume des transactions automatisées était très raisonnable en 2007 et qu'il a pris ces dernières années des proportions inquiétantes. Certains disent qu'il faut y voir une des raisons de la crise financière et des variations excessives que connaissent les marchés et qui font la joie de Thomas Blar ! Ce n'est pas mon propos ici :-)

Pour représenter des données qui contiennent un axe temporel, il ne faut pas hésiter à utiliser des graphiques dynamiques. Le mouvement représente le temps - la date est d'ailleurs bien indiquée en bas à gauche. Et l'accélération du temps fait prendre conscience du phénomène.

Faut-il des outils complexes et coûteux pour y parvenir ? Pas du tout ! Cette animation est un simple fichier "gif animé", c'est à dire une succession d'images fixes, que le gif animé fait défiler à vitesse rapide. Tout comme la roue de Faraday en 1830, le gif animé joue sur la persistence rétinienne pour faire croire à l'oeil qu'on lui présente un mouvement alors qu'il ne s'agit que d'une suite d'images fixes.

Pas besoin de logiciels couteux et complexes, avec un peu d'imagination, vous pourrez vous aussi animer vos images.

Faire du big data, c'est bien sur collecter, stocker et analyser de grandes quantités de données, mais c'est aussi les représenter sous forme graphique le plus souvent, afin d'en faire comprendre le message à son public. Je crois beaucoup à la force du "V" de la visualisation !

Partager ce site

Tags

Archives

Profil

Je suis journaliste, formateur et auteur, spécialiste de l'informatique décisionnelle. Passionné par l'évolution de ce domaine vers le "Big Data", également appelé "Données Volumineuses", j'ai décidé d'écrire un livre en français sur le sujet, peut-être le premier. Etudes de cas, panorama des outils, vision des experts... et les coulisses de la production du livre, que je vous propose de découvrir au fil de ces billets.

Philippe NIEUWBOURG

Philippe NIEUWBOURG

Dernières notes