Jour d’élection aux États-Unis, les regards et les discussions étaient tournées vers les urnes. Trump ou Clinton, qui sera le prochain Président des Etats-Unis ? Les spécialistes de la visualisation graphique peuvent tenter de trouver une représentation innovante, mais le choix reste binaire. Et semble d’ailleurs ne satisfaire personne.

Avant que le choix des électeurs américains ne soit annoncé, c’est le Président de Tableau, Christian Chabot, qui avait pris la parole à Austin, au coeur du Texas, devant 13 000 clients et partenaires réunis pour la conférence annuelle de l’éditeur. Après l’ambiance festive de Las Vegas en 2015, celle de Austin est bien différente; le sud des Etats-Unis semble presque à l’opposé de Seattle, domicile de l’éditeur.

La conférence d’ouverture a été l’occasion pour Christian Chabot de tracer les grandes lignes du plan de développement de l’éditeur à trois ans. Et c’était attendu !

En effet, la principale critique que doit supporter Tableau est son produit unique, et un manque de lisibilité sur ses développements à moyen terme. Une discrétion acceptée lorsque la compagnie était privée, mais qui l’est beaucoup moins maintenant que l’entreprise est cotée en bourse. Les analystes financiers et les investisseurs veulent savoir quelle direction prendra l’entreprise dans les prochaines années, avant de se positionner à l’achat ou à la vente. Pour les clients, qui doivent choisir le produit qui les accompagnera pendant plusieurs années, cette lisibilité est également un élément clef de leur choix.

Du point de vue produit, les critiques exprimées par ces clients tournent autour de deux points : la performance qui chute de manière dramatique lorsque les volumes commencent à être importants (et cette situation survient généralement douze à dix-huit mois après le début du déploiement par une entreprise); et la complexité d’administration et d’intégration au système d’information d’un grand nombre d’utilisateurs.

Tableau a voulu clairement répondre à ces questions. Et Christian Chabot a dévoilé plusieurs évolutions intéressantes. “La conférence annuelle de Tableau est une opportunité pour nous de partager notre vision à long terme, et d’expliquer comment nous pouvons aider nos clients à obtenir plus de leurs données”, explique Elissa Fink, Chief Marketing Officer de l’éditeur.

Avant que le choix des électeurs américains ne soit annoncé, c’est le Président de Tableau, Christian Chabot, qui avait pris la parole à Austin, au coeur du Texas, devant 13 000 clients et partenaires réunis pour la conférence annuelle de l’éditeur. Après l’ambiance festive de Las Vegas en 2015, celle de Austin est bien différente; le sud des Etats-Unis semble presque à l’opposé de Seattle, domicile de l’éditeur.

La conférence d’ouverture a été l’occasion pour Christian Chabot de tracer les grandes lignes du plan de développement de l’éditeur à trois ans. Et c’était attendu !

En effet, la principale critique que doit supporter Tableau est son produit unique, et un manque de lisibilité sur ses développements à moyen terme. Une discrétion acceptée lorsque la compagnie était privée, mais qui l’est beaucoup moins maintenant que l’entreprise est cotée en bourse. Les analystes financiers et les investisseurs veulent savoir quelle direction prendra l’entreprise dans les prochaines années, avant de se positionner à l’achat ou à la vente. Pour les clients, qui doivent choisir le produit qui les accompagnera pendant plusieurs années, cette lisibilité est également un élément clef de leur choix.

Du point de vue produit, les critiques exprimées par ces clients tournent autour de deux points : la performance qui chute de manière dramatique lorsque les volumes commencent à être importants (et cette situation survient généralement douze à dix-huit mois après le début du déploiement par une entreprise); et la complexité d’administration et d’intégration au système d’information d’un grand nombre d’utilisateurs.

Tableau a voulu clairement répondre à ces questions. Et Christian Chabot a dévoilé plusieurs évolutions intéressantes. “La conférence annuelle de Tableau est une opportunité pour nous de partager notre vision à long terme, et d’expliquer comment nous pouvons aider nos clients à obtenir plus de leurs données”, explique Elissa Fink, Chief Marketing Officer de l’éditeur.

Intégration de la technologie HyPer acquise en début d’année

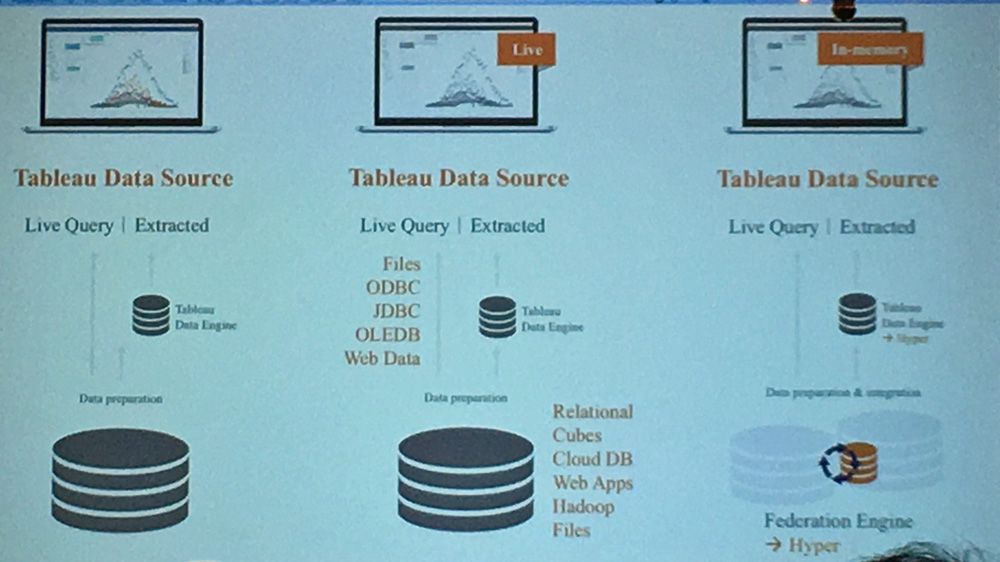

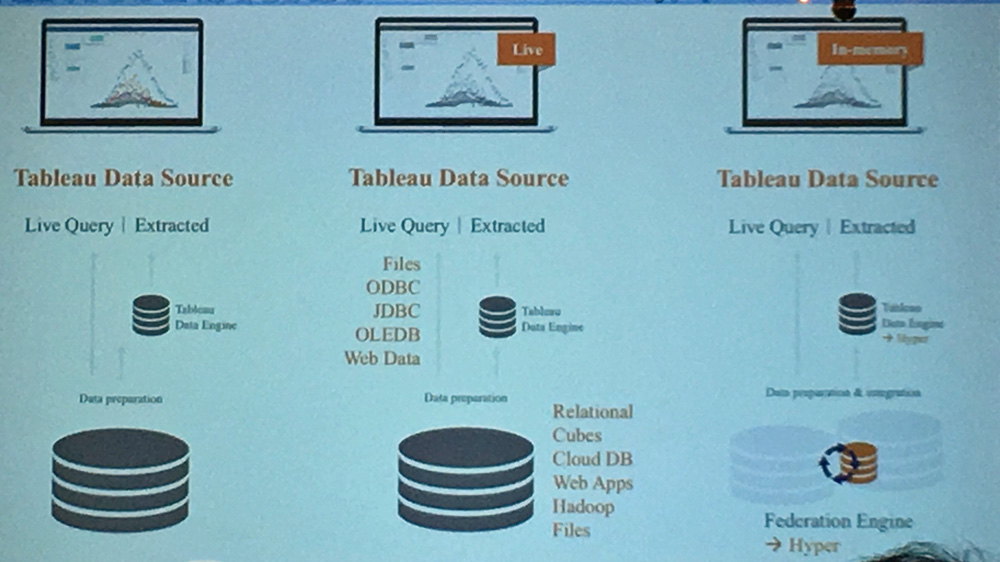

Pour accélérer les traitements en mémoire de gros volumes de données, Tableau a acquis une technologie Allemande, dont l’équipe a rejoint l’éditeur en mars de cette année. Mais l’intégration restait à faire. Elle est en cours, et l’éditeur annonce la disponibilité du produit en 2017. Également annoncée pour 2017, une version de Tableau Server est en cours de développement sous Linux.

Présentée par Patrice Pelland, en charge de l’équipe “base de données” chez Tableau, Hyper a vocation à remplacer, progressivement, le Tableau Data Engine actuel. Une évolution qui se justifierait par la croissance des volumes de données analysées par les clients, les besoins de rafraîchissement de plus fréquents (en particulier pour analyser les données de l’Internet des objets), et le fameux problème de baisse des performances auquel Tableau devait apporter une solution. Hyper sera donc le nouvel outil de stockage de données intermédiaire dans Tableau, mais également dans le futur Maestro (voir ci-dessous).

Il devrait permettre, selon Tableau, d’analyser des jeux de données de plusieurs milliards de lignes, et d’offrir des rafraîchissements proches du temps réel. Les performances devraient être conservées, même lorsqu’un grand nombre d’utilisateurs est connecté à Hyper.

Point intéressant, Hyper identifie les “transactions” qu’il ingère. Cela permet par exemple de sélectionner automatiquement les deux dernières heures, ou la dernière semaine de données, et les résultats de la requête “glisseront” automatiquement au fil du temps. Une caractéristique encore une fois intéressante pour l’analyse des données en provenance de capteurs.

Bien sur, la phase de transition pose question. Comment se déroulera le remplacement de TDE par Hyper, et cela sera-t-il vraiment transparent pour les utilisateurs, dont des centaines d’analyses s’appuient actuellement sur TDE ?

Le planning de sortie de Hyper est pour l’instant conservateur. Tableau Public devrait être le premier service à en bénéficier, d’ici quelques semaines. Cela permettra à Tableau de tester Hyper dans un environnement qu’il maîtrise, mais avec de gros volumes de données et un grand nombre d’utilisateurs. Puis une version Alpha est prévue au premier trimestre 2017, une version Beta au deuxième, et le lancement du produit au troisième trimestre 2017. Il reste donc une année à patienter.

Les versions d’essai et les versions d’entrée de gamme ne devraient pas être concernées, et Hyper n’y sera pas intégré. Mais toutes les autres plateformes (Linux, Windows, Mac) évolueront, de manière automatique, sans migration, de Tableau Data Engine vers Hyper.

A terme, Hyper sera la base de données de fédération de la plateforme Tableau. Mais on ne connaît pas encore le modèle de vente de Hyper. Sera-t-il inclus dans Tableau ? Sans doute pas, car Tableau doit générer des revenus supplémentaires.

Présentée par Patrice Pelland, en charge de l’équipe “base de données” chez Tableau, Hyper a vocation à remplacer, progressivement, le Tableau Data Engine actuel. Une évolution qui se justifierait par la croissance des volumes de données analysées par les clients, les besoins de rafraîchissement de plus fréquents (en particulier pour analyser les données de l’Internet des objets), et le fameux problème de baisse des performances auquel Tableau devait apporter une solution. Hyper sera donc le nouvel outil de stockage de données intermédiaire dans Tableau, mais également dans le futur Maestro (voir ci-dessous).

Il devrait permettre, selon Tableau, d’analyser des jeux de données de plusieurs milliards de lignes, et d’offrir des rafraîchissements proches du temps réel. Les performances devraient être conservées, même lorsqu’un grand nombre d’utilisateurs est connecté à Hyper.

Point intéressant, Hyper identifie les “transactions” qu’il ingère. Cela permet par exemple de sélectionner automatiquement les deux dernières heures, ou la dernière semaine de données, et les résultats de la requête “glisseront” automatiquement au fil du temps. Une caractéristique encore une fois intéressante pour l’analyse des données en provenance de capteurs.

Bien sur, la phase de transition pose question. Comment se déroulera le remplacement de TDE par Hyper, et cela sera-t-il vraiment transparent pour les utilisateurs, dont des centaines d’analyses s’appuient actuellement sur TDE ?

Le planning de sortie de Hyper est pour l’instant conservateur. Tableau Public devrait être le premier service à en bénéficier, d’ici quelques semaines. Cela permettra à Tableau de tester Hyper dans un environnement qu’il maîtrise, mais avec de gros volumes de données et un grand nombre d’utilisateurs. Puis une version Alpha est prévue au premier trimestre 2017, une version Beta au deuxième, et le lancement du produit au troisième trimestre 2017. Il reste donc une année à patienter.

Les versions d’essai et les versions d’entrée de gamme ne devraient pas être concernées, et Hyper n’y sera pas intégré. Mais toutes les autres plateformes (Linux, Windows, Mac) évolueront, de manière automatique, sans migration, de Tableau Data Engine vers Hyper.

A terme, Hyper sera la base de données de fédération de la plateforme Tableau. Mais on ne connaît pas encore le modèle de vente de Hyper. Sera-t-il inclus dans Tableau ? Sans doute pas, car Tableau doit générer des revenus supplémentaires.

Après l’analyse de données, Tableau prépare un outil d’intégration, Maestro

Christian Chabot nous l’avait dévoilé il y a quatre ans, à Barcelone, son prochain projet était de lancer un outil de préparation et d’intégration de données aussi simple à utiliser que Tableau.

Encore aujourd’hui, l’essentiel du temps des coûteux Data Scientists est en réalité consacré à manipuler des données, les arranger, les nettoyer, les filtrer, etc. Pas forcément très intéressant comme occupation pour un PhD !

Tableau travaille donc sur un nouveau produit, dont le nom de code est Maestro. Maestro sera un outil de préparation de données, visuel et interactif. La force de Maestro sera d’être intégré à ce qui devient un écosystème. Avec Maestro, Tableau devient éditeur d’une plateforme et passe de mono-produit à une gamme : Tableau Desktop, Server, Hyper, Maestro…

La réalité des analystes de données est très différente de la fluidité des flux de données que l’on a coutume de décrire. Bon nombre d’entre eux continuent d’utiliser Excel comme outil de préparation de données. Excel est un très bon outil, mais il casse totalement les efforts de gouvernance et de qualité de données mis en place en amont par le département informatique. Cependant pour les utilisateurs d’affaires il n’y a souvent aucune autre solution à leur disposition : les ETL sont trop coûteux et surtout trop complexes pour être manipulés par des responsables d’affaires, et le département informatique n’est pas suffisamment réactif par rapport à leurs demandes qui évoluent en permanence.

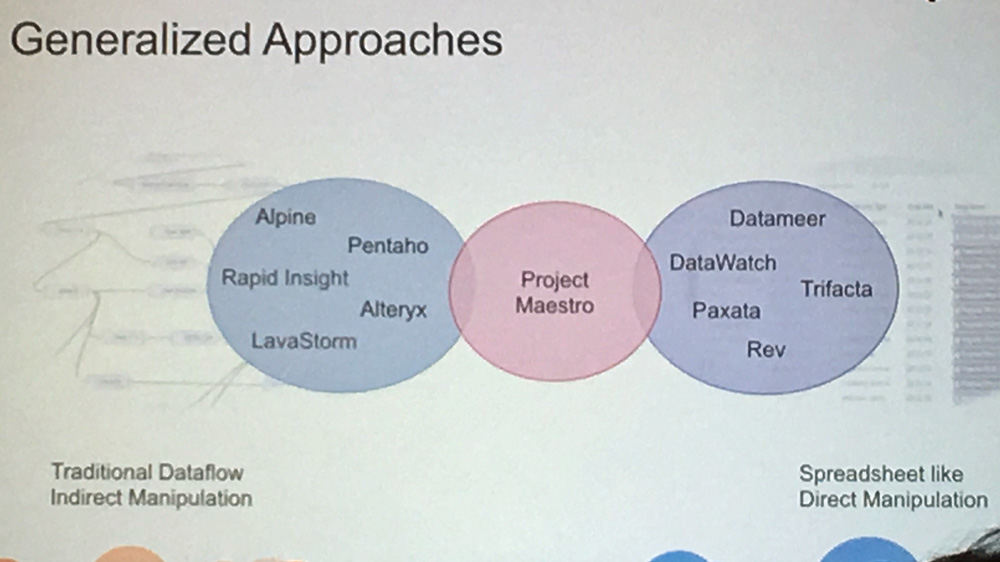

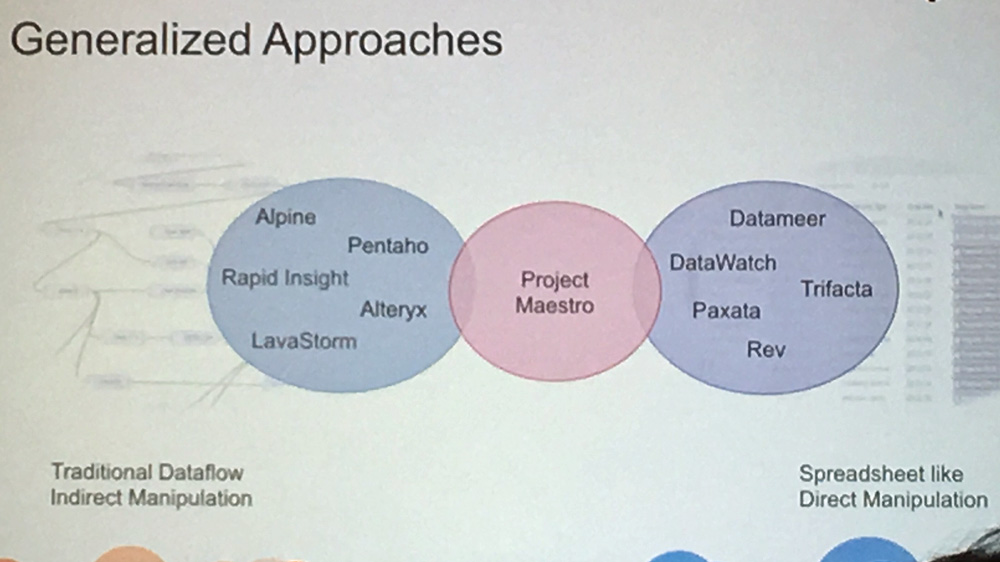

Tableau identifie deux catégories d’outils de préparation de données : les outils à base de flux de données (Alpine, Alteryx, Pentaho…), et les outils en mode feuille de calcul (Datawatch, Trifacta, Datameer…). Soucieux de ne pas se mettre à dos ceux qui sont actuellement des apporteurs d’affaires, Tableau essaye de se positionner entre les deux, espérant ne fâcher personne… Le peu d’informations distillées pour l’instant sur Maestro laisse à penser qu’il s’agit juste d’une tentative marketing, qui ne résistera pas au lancement réel du produit. Tableau Maestro sera très certainement concurrent de tous ces outils; il n’y a vraiment pas de raison de les cumuler. Et Tableau devra apprendre à gérer ces nouvelles relations de co-opétition.

Maestro se veut l’outil quotidien du data steward. Un produit développé suivant les principes d’interface visuelle de Tableau, installé sur le poste de l’utilisateur ou accessible via un navigateur, et bien sûr intégré à Tableau, et à Hyper. En revanche, en terme de fonctionnalités, Maestro sera dans un premier temps très en retard par rapport à ses concurrents. Aucun calendrier n’est annoncé pour la prise en charge de fonctions de gestion de la qualité des données (DQM), ou de gestion des données de référence (MDM).

Maestro n’est pour l’instant qu’un projet, et aucune démonstration ne nous a été présentée à ce jour; pas plus qu’une date de disponibilité, dont on peut penser qu’elle se situera plutôt vers la fin de l’année 2017. Aucune grille de prix n’a été annoncée.

Encore aujourd’hui, l’essentiel du temps des coûteux Data Scientists est en réalité consacré à manipuler des données, les arranger, les nettoyer, les filtrer, etc. Pas forcément très intéressant comme occupation pour un PhD !

Tableau travaille donc sur un nouveau produit, dont le nom de code est Maestro. Maestro sera un outil de préparation de données, visuel et interactif. La force de Maestro sera d’être intégré à ce qui devient un écosystème. Avec Maestro, Tableau devient éditeur d’une plateforme et passe de mono-produit à une gamme : Tableau Desktop, Server, Hyper, Maestro…

La réalité des analystes de données est très différente de la fluidité des flux de données que l’on a coutume de décrire. Bon nombre d’entre eux continuent d’utiliser Excel comme outil de préparation de données. Excel est un très bon outil, mais il casse totalement les efforts de gouvernance et de qualité de données mis en place en amont par le département informatique. Cependant pour les utilisateurs d’affaires il n’y a souvent aucune autre solution à leur disposition : les ETL sont trop coûteux et surtout trop complexes pour être manipulés par des responsables d’affaires, et le département informatique n’est pas suffisamment réactif par rapport à leurs demandes qui évoluent en permanence.

Tableau identifie deux catégories d’outils de préparation de données : les outils à base de flux de données (Alpine, Alteryx, Pentaho…), et les outils en mode feuille de calcul (Datawatch, Trifacta, Datameer…). Soucieux de ne pas se mettre à dos ceux qui sont actuellement des apporteurs d’affaires, Tableau essaye de se positionner entre les deux, espérant ne fâcher personne… Le peu d’informations distillées pour l’instant sur Maestro laisse à penser qu’il s’agit juste d’une tentative marketing, qui ne résistera pas au lancement réel du produit. Tableau Maestro sera très certainement concurrent de tous ces outils; il n’y a vraiment pas de raison de les cumuler. Et Tableau devra apprendre à gérer ces nouvelles relations de co-opétition.

Maestro se veut l’outil quotidien du data steward. Un produit développé suivant les principes d’interface visuelle de Tableau, installé sur le poste de l’utilisateur ou accessible via un navigateur, et bien sûr intégré à Tableau, et à Hyper. En revanche, en terme de fonctionnalités, Maestro sera dans un premier temps très en retard par rapport à ses concurrents. Aucun calendrier n’est annoncé pour la prise en charge de fonctions de gestion de la qualité des données (DQM), ou de gestion des données de référence (MDM).

Maestro n’est pour l’instant qu’un projet, et aucune démonstration ne nous a été présentée à ce jour; pas plus qu’une date de disponibilité, dont on peut penser qu’elle se situera plutôt vers la fin de l’année 2017. Aucune grille de prix n’a été annoncée.

Parlez à votre outil de BI, il va vous comprendre

Dans une prochaine version, Tableau intégrera de l’apprentissage machine directement dans l’outil. L’objectif est de faciliter la production d’analyses par les utilisateurs, en leur recommandant les meilleures visualisation par rapport aux données soumises.

Mais c’est surtout l’interface utilisateur qui va évoluer, en intégrant une interface en langage naturel. Plus besoin de chercher dans les variables et les dimensions, il suffit de poser la question (pour l’instant en anglais) : “Quels sont les dix clients les plus profitables du dernier trimestre ?”; et Tableau construit la visualisation graphique correspondante. De plus, le système tente de comprendre votre demande au fur et à mesure de sa rédaction et vous propose de compléter la phrase.

Ces développements ont fait l’objet d’un intéressant article de recherche publié par Vidya Setlur, Senior Research Scientist chez Tableau, en charge de ces développements.

Pas de mention de reconnaissance vocale pour l’instant, mais on notera la présence d’une icône de microphone à droite du champ de saisie, qui permettra certainement de dicter sa demande. Assistera-t-on à la naissance d’une nouvelle forme de “BI Conversationnelle”, plus complète que les simples “chatbots” ? Les premières démonstrations sont prometteuses.

Mais c’est surtout l’interface utilisateur qui va évoluer, en intégrant une interface en langage naturel. Plus besoin de chercher dans les variables et les dimensions, il suffit de poser la question (pour l’instant en anglais) : “Quels sont les dix clients les plus profitables du dernier trimestre ?”; et Tableau construit la visualisation graphique correspondante. De plus, le système tente de comprendre votre demande au fur et à mesure de sa rédaction et vous propose de compléter la phrase.

Ces développements ont fait l’objet d’un intéressant article de recherche publié par Vidya Setlur, Senior Research Scientist chez Tableau, en charge de ces développements.

Pas de mention de reconnaissance vocale pour l’instant, mais on notera la présence d’une icône de microphone à droite du champ de saisie, qui permettra certainement de dicter sa demande. Assistera-t-on à la naissance d’une nouvelle forme de “BI Conversationnelle”, plus complète que les simples “chatbots” ? Les premières démonstrations sont prometteuses.

Ne soyez plus seul, collaborez dans Tableau

C’est sans doute en matière de collaboration que les fonctionnalités annoncées sont le moins intéressantes. Il s’agit en effet plus d’un rattrapage par Tableau, dans un domaine où des concurrents comme Yellowfin avaient pris une avance certaine.

Vous pourrez donc maintenant dans Tableau, commenter, discuter, échanger autour des informations ou des graphiques. Chaque feuille disposera d’un fil de discussion. Ce fil de discussion sera également disponible sur mobile, avec des notifications automatiques lorsqu’un fil de discussion que vous suivez est modifié.

C’est intéressant, mais on peut se demander si une intégration avec des outils externes comme Slack ou Yammer n’aurait pas été préférable.

Vous pourrez donc maintenant dans Tableau, commenter, discuter, échanger autour des informations ou des graphiques. Chaque feuille disposera d’un fil de discussion. Ce fil de discussion sera également disponible sur mobile, avec des notifications automatiques lorsqu’un fil de discussion que vous suivez est modifié.

C’est intéressant, mais on peut se demander si une intégration avec des outils externes comme Slack ou Yammer n’aurait pas été préférable.

En résumé, beaucoup de belles annonces, et Tableau répond clairement aux attentes en matière de visibilité sur ses développements en cours. Sur son potentiel de développement commercial, l’éditeur devra encore convaincre ses clients de dépenser plus, en acquérant de nouveaux produits. Une grande banque canadienne, croisée lors de la conférence expliquait qu’après avoir fait rentrer Tableau pour ses capacités d’analyse et de visualisation, il sera sans doute difficile de faire accepter un produit de plus, qui viendrait en recouvrement avec les autres ETL déjà installés. Tout dépendra donc du positionnement prix, et de la démarche commerciale que Tableau mettra en oeuvre.

Mais ce que l’on retient aussi de cette conférence, c’est qu’il s’agit d’annonces, et rien de concret n’est disponible aujourd’hui. Si vous savez attendre 2017, l’année devrait être riche en évolutions fonctionnelles pour Tableau. Soyons honnêtes, Tableau a toujours su, jusqu’à présent, livrer les fonctionnalités promises, et dans les temps indiqués. Ne leur faisons donc pas de procès d’intention, et attendons 2017 pour tester Hyper et Maestro dans les conditions réelles.

Mais ce que l’on retient aussi de cette conférence, c’est qu’il s’agit d’annonces, et rien de concret n’est disponible aujourd’hui. Si vous savez attendre 2017, l’année devrait être riche en évolutions fonctionnelles pour Tableau. Soyons honnêtes, Tableau a toujours su, jusqu’à présent, livrer les fonctionnalités promises, et dans les temps indiqués. Ne leur faisons donc pas de procès d’intention, et attendons 2017 pour tester Hyper et Maestro dans les conditions réelles.

Autres articles

-

Salesforce dévoile une mise à jour de Tableau Einstein pour intégrer les agents IA autonomes sur sa plateforme analytique

-

Avec une capacité de traitement de 100 milliards d’interactions par jour, Salesforce Genie Customer Data Cloud et Tableau accélèrent la prise de décision en entreprise

-

Salesforce annonce la nomination de Jean-David Benassouli au poste de Vice-Président Analytics, à la tête de Tableau en France

-

Pour 87% des décideurs, la donnée est une source d'innovation et de croissance mais plus d'un tiers (34%) estime que leur entreprise passe à côté d'opportunités

-

Les horizons multiples qu'ouvre l'Intelligence Artificielle en 2018