Abed Ajraou,

Responsable du Centre de Compétence EIM, Devoteam

Ce n’est plus trahir un secret que d’affirmer que la Business Intelligence, dite traditionnelle, atteint ses limites :

• Un datawarehouse de quelques téraoctets est très compliqué à maintenir et à faire évoluer.

• Les données non-structurées n’ont jamais été abordées par la Business Intelligence – pensant que les données structurées étaient suffisantes pour la prise de décision – tel un nombrilisme méprisant.

• La BI temps réel – grand paradigme de ces dernières années – n’a été atteinte qu’au prix d’architectures ultra-complexes, coûteuses et dont le retour sur investissement a toujours été contesté.

Pourquoi remuer le couteau dans la plaie de la Business Intelligence aujourd’hui ? Pour au moins deux bonnes raisons :

1. Se limiter à quelques téraoctets dans l’entrepôt de données n’est aujourd’hui plus possible. L’accroissement de la volumétrie des données à analyser dans l’entreprise suit une loi dite exponentielle et il est urgent de traiter ce problème avant d’être complètement submergé.

2. Les données semi-structurées, voir non-structurées, sont de plus en plus présentes dans l’écosystème de l’entreprise (fichiers de logs, RSE, catalogue produits, blogs …) ; et les données externes à l’entreprise sont de plus en plus prisées (réseaux sociaux, articles de presse, vidéo …). En effet, il est impossible d’exploiter ses informations avec les techniques classiques de la Business Intelligence sans monter des architectures et des infrastructures extrêmement alambiquées et qui de plus ne cibleront qu’un seul type de besoin.

• Un datawarehouse de quelques téraoctets est très compliqué à maintenir et à faire évoluer.

• Les données non-structurées n’ont jamais été abordées par la Business Intelligence – pensant que les données structurées étaient suffisantes pour la prise de décision – tel un nombrilisme méprisant.

• La BI temps réel – grand paradigme de ces dernières années – n’a été atteinte qu’au prix d’architectures ultra-complexes, coûteuses et dont le retour sur investissement a toujours été contesté.

Pourquoi remuer le couteau dans la plaie de la Business Intelligence aujourd’hui ? Pour au moins deux bonnes raisons :

1. Se limiter à quelques téraoctets dans l’entrepôt de données n’est aujourd’hui plus possible. L’accroissement de la volumétrie des données à analyser dans l’entreprise suit une loi dite exponentielle et il est urgent de traiter ce problème avant d’être complètement submergé.

2. Les données semi-structurées, voir non-structurées, sont de plus en plus présentes dans l’écosystème de l’entreprise (fichiers de logs, RSE, catalogue produits, blogs …) ; et les données externes à l’entreprise sont de plus en plus prisées (réseaux sociaux, articles de presse, vidéo …). En effet, il est impossible d’exploiter ses informations avec les techniques classiques de la Business Intelligence sans monter des architectures et des infrastructures extrêmement alambiquées et qui de plus ne cibleront qu’un seul type de besoin.

L’éléphant jaune ouvre de nouvelles perspectives à la Business Intelligence

Lorsque l’on parle de volume, de variété et de vélocité, on pense naturellement à Google, Yahoo, Facebook, Linkedin … Et c’est bien ces deux premiers géants qui ont commencés à réfléchir à ces problématiques (il y a déjà plusieurs années) et qui nous ouvrent aujourd’hui la voie vers des possibilités que l’on croyait totalement utopiques il y a à peine quelques mois !

Hadoop – ce petit éléphant jaune, mignon soit-il - est en fait tout un framework open source qui permet de disposer d’une architecture logicielle scalable (massivement processing parallèle) grâce à un cluster de machines. Quésako ? C’est assez simple à vrai dire : la philosophie d’Hadoop déporte la problématique technique (hardware) du stockage de la donnée vers une gestion logicielle. Hadoop HDFS – c'est-à-dire le stockage de l’information sur les fichiers systèmes – permet de gérer intelligemment des données en exploitant au maximum les machines serveurs en réseaux (cluster de machines). Comment fait-il ? Tout simplement en gardant le principe du «zero fault tolerance» … Vous remarquerez qu’il est extrêmement rare de voir Google ou Facebook en panne. Ceci est dû au fait que si un serveur est débranché, il n’y aura aucun impact car d’autres serveurs prendront le relais – tant en terme de service rendu qu’en terme de stockage de l’information ! Hadoop stocke effectivement toute l’information trois fois et en fragments distribués sur les différentes machines du cluster.

Et … c’est tout ? Non, comment l’interrogation des données est aussi rapide sur Google ? Parce que Google est le précurseur du framework map/reduce qui fait partie du monde Hadoop. Map/Reduce permet d’exploiter ici la puissance de chaque machine et de réduire l’interrogation en petites interrogations et ensuite rassemble l’ensemble des résultats en un résultat final. Le temps de réponse sur une volumétrie très grande est juste édifiant !

Donc, nous avons une meilleure disponibilité des données, un traitement des données très rapide … En quoi cela permet d’avoir une BI plus évoluée ? Ce serait un grand manquement que de parler d’Hadoop sans évoquer le NoSQL et en particulier de HBase. HBase est une base de données orientée colonne. Elle est totalement adaptée à la recherche d’information car sa structure est basée sur le principe du « Clé, Valeur » ce qui permet le lien de toutes les informations entre-elles. En clair, le stockage de l’information est beaucoup plus intelligent et adapté à la recherche de données et donc à la Business Intelligence. Au passage, les bases NoSQL sont automatiquement compressées ce qui donne plus de souplesse au niveau de l’optimisation de l’espace de stockage.

Hadoop – ce petit éléphant jaune, mignon soit-il - est en fait tout un framework open source qui permet de disposer d’une architecture logicielle scalable (massivement processing parallèle) grâce à un cluster de machines. Quésako ? C’est assez simple à vrai dire : la philosophie d’Hadoop déporte la problématique technique (hardware) du stockage de la donnée vers une gestion logicielle. Hadoop HDFS – c'est-à-dire le stockage de l’information sur les fichiers systèmes – permet de gérer intelligemment des données en exploitant au maximum les machines serveurs en réseaux (cluster de machines). Comment fait-il ? Tout simplement en gardant le principe du «zero fault tolerance» … Vous remarquerez qu’il est extrêmement rare de voir Google ou Facebook en panne. Ceci est dû au fait que si un serveur est débranché, il n’y aura aucun impact car d’autres serveurs prendront le relais – tant en terme de service rendu qu’en terme de stockage de l’information ! Hadoop stocke effectivement toute l’information trois fois et en fragments distribués sur les différentes machines du cluster.

Et … c’est tout ? Non, comment l’interrogation des données est aussi rapide sur Google ? Parce que Google est le précurseur du framework map/reduce qui fait partie du monde Hadoop. Map/Reduce permet d’exploiter ici la puissance de chaque machine et de réduire l’interrogation en petites interrogations et ensuite rassemble l’ensemble des résultats en un résultat final. Le temps de réponse sur une volumétrie très grande est juste édifiant !

Donc, nous avons une meilleure disponibilité des données, un traitement des données très rapide … En quoi cela permet d’avoir une BI plus évoluée ? Ce serait un grand manquement que de parler d’Hadoop sans évoquer le NoSQL et en particulier de HBase. HBase est une base de données orientée colonne. Elle est totalement adaptée à la recherche d’information car sa structure est basée sur le principe du « Clé, Valeur » ce qui permet le lien de toutes les informations entre-elles. En clair, le stockage de l’information est beaucoup plus intelligent et adapté à la recherche de données et donc à la Business Intelligence. Au passage, les bases NoSQL sont automatiquement compressées ce qui donne plus de souplesse au niveau de l’optimisation de l’espace de stockage.

Le renouveau des architectures décisionnelles

Tous les professionnels de la Business Intelligence savent qu’une architecture type de données est constituée d’un ODS (Operational Data Storage), un DWH et des DataMarts. Ces strates de données ne sont pas obligatoires mais assez classiques et sont alimentées, en règle générale, par des techniques dites ETL (extraction, transformation et chargement - via un logiciel ou en programmation pure). Les puristes me diront qu’il manque la « Staging Area », cette couche de données qui n’est en fait qu’une copie des données sources.

Quelle est donc la nouvelle architecture des données via le petit éléphant jaune qui supporterait le volume, les données non-structurées et la vélocité ?

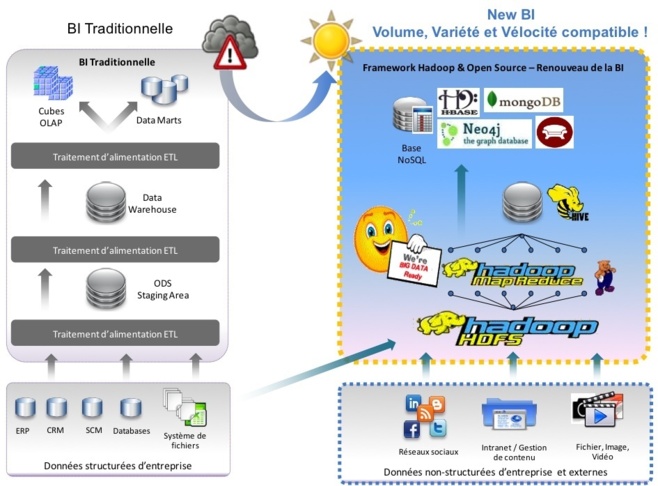

Voici un petit face à face entre les architectures de données de la BI classique et le framework Hadoop :

• L’ODS serait Hadoop HDFS car il stocke les données brutes des différents systèmes. Certains diront qu’il s’agit là plus de la Staging Area, je ne suis pas vraiment convaincu car nous pouvons par exemple concaténer des fichiers sources disparates directement dans Hadoop HDFS.

• La nouvelle génération d’ETL serait le framework Map/Reduce – les plus sceptiques diront que le fait de coder du java pour utiliser le framework Map/Reduce est une régression vu les interfaces des logiciels ETL actuels. Mais il n’en n’est rien ! Pig – ce logiciel faisant partie du monde Hadoop - permet justement cette abstraction Java et le langage de programmation de Pig est à la portée de n’importe quel informaticien.

• Le datawarehouse serait Hive qui utilise directement le framework map/reduce pour toutes requêtes SQL d’alimentation et de sélection … Ce qui permet un temps de calcul extrêmement rapide lorsque l’on traite des hautes volumétries et ceci permet ainsi de disposer d’une architecture « quasi-temps réel » à moindre frais.

• Pour les datamarts et les cubes multidimensionnels, nous avons l’embarras du choix au gré des circonstances. En effet, nous avons Hbase comme vu ci-dessus, mais il en existe plusieurs qui peuvent répondre à des besoins spécifiques. Citons par exemple Neo4j qui est une base NoSQL en graphes – idéale lorsque l’on souhaite exploiter et analyser des réseaux de liens (réseaux sociaux, ou encore réseaux de neurones …)- ou encore MongoDb qui est une base NoSQL documentaire – idéale pour le stockage de documents dans le cas où l’on souhaite exploiter ou analyser des articles web, des articles de presse…

L’architecture décisionnelle se voit complètement transformée :

Quelle est donc la nouvelle architecture des données via le petit éléphant jaune qui supporterait le volume, les données non-structurées et la vélocité ?

Voici un petit face à face entre les architectures de données de la BI classique et le framework Hadoop :

• L’ODS serait Hadoop HDFS car il stocke les données brutes des différents systèmes. Certains diront qu’il s’agit là plus de la Staging Area, je ne suis pas vraiment convaincu car nous pouvons par exemple concaténer des fichiers sources disparates directement dans Hadoop HDFS.

• La nouvelle génération d’ETL serait le framework Map/Reduce – les plus sceptiques diront que le fait de coder du java pour utiliser le framework Map/Reduce est une régression vu les interfaces des logiciels ETL actuels. Mais il n’en n’est rien ! Pig – ce logiciel faisant partie du monde Hadoop - permet justement cette abstraction Java et le langage de programmation de Pig est à la portée de n’importe quel informaticien.

• Le datawarehouse serait Hive qui utilise directement le framework map/reduce pour toutes requêtes SQL d’alimentation et de sélection … Ce qui permet un temps de calcul extrêmement rapide lorsque l’on traite des hautes volumétries et ceci permet ainsi de disposer d’une architecture « quasi-temps réel » à moindre frais.

• Pour les datamarts et les cubes multidimensionnels, nous avons l’embarras du choix au gré des circonstances. En effet, nous avons Hbase comme vu ci-dessus, mais il en existe plusieurs qui peuvent répondre à des besoins spécifiques. Citons par exemple Neo4j qui est une base NoSQL en graphes – idéale lorsque l’on souhaite exploiter et analyser des réseaux de liens (réseaux sociaux, ou encore réseaux de neurones …)- ou encore MongoDb qui est une base NoSQL documentaire – idéale pour le stockage de documents dans le cas où l’on souhaite exploiter ou analyser des articles web, des articles de presse…

L’architecture décisionnelle se voit complètement transformée :

Un accélérateur pour l’analyse de données.

Comme le dit si bien Laurence Hubert, le Big Data est en fait un supercalculateur à la disposition de tout le monde. Je suis de cet avis.

Lorsque l’on souhaite faire des analyses sur une population assez grande, chaque statisticien sait que le plus long du travail consiste à échantillonner cette population, en l’étudiant en profondeur car l’échantillonnage va être un facteur clé de réussite du sondage à effectuer. Le petit éléphant jaune va aussi bouleverser cela.

L’échantillon était réalisé car il était impossible, en termes de temps et de budget, d’analyser l’ensemble de la population. Cette méthode indispensable dans le monde des statistiques est aujourd’hui remise en cause. Nous sommes effectivement aujourd’hui dans la capacité de stocker et d’analyser très rapidement une volumineuse masse d’information. Alors pourquoi se priver de l’exploitation de l’ensemble de l’information réelle ?

Jeffrey Breen a comparé un sondage réalisé par ACSI (The American Customer Satisfaction Index) et les tweets récoltés sur le réseau social Tweeter au sujet de leurs satisfactions sur les compagnies d’avions américaines (les résultats de cette étude ont été communiqués lors du « Boston Predictive Analytics Meet Up »). Il s’avère que les conclusions montrent que l’analyse des tweets (en faisant une analyse de sentiments) donne des résultats très proches du sondage réalisé.

Dans ce monde ultra-connecté aux réseaux, il devient indispensable d’exploiter l’ensemble de ses informations qui peuvent conduire à de nouvelles analyses et donc permettre de nouvelles opportunités d’affaires.

Nous verrons dans un autre billet, les changements potentiels en termes de reporting et d’outil d’analyse.

Lorsque l’on souhaite faire des analyses sur une population assez grande, chaque statisticien sait que le plus long du travail consiste à échantillonner cette population, en l’étudiant en profondeur car l’échantillonnage va être un facteur clé de réussite du sondage à effectuer. Le petit éléphant jaune va aussi bouleverser cela.

L’échantillon était réalisé car il était impossible, en termes de temps et de budget, d’analyser l’ensemble de la population. Cette méthode indispensable dans le monde des statistiques est aujourd’hui remise en cause. Nous sommes effectivement aujourd’hui dans la capacité de stocker et d’analyser très rapidement une volumineuse masse d’information. Alors pourquoi se priver de l’exploitation de l’ensemble de l’information réelle ?

Jeffrey Breen a comparé un sondage réalisé par ACSI (The American Customer Satisfaction Index) et les tweets récoltés sur le réseau social Tweeter au sujet de leurs satisfactions sur les compagnies d’avions américaines (les résultats de cette étude ont été communiqués lors du « Boston Predictive Analytics Meet Up »). Il s’avère que les conclusions montrent que l’analyse des tweets (en faisant une analyse de sentiments) donne des résultats très proches du sondage réalisé.

Dans ce monde ultra-connecté aux réseaux, il devient indispensable d’exploiter l’ensemble de ses informations qui peuvent conduire à de nouvelles analyses et donc permettre de nouvelles opportunités d’affaires.

Nous verrons dans un autre billet, les changements potentiels en termes de reporting et d’outil d’analyse.

Les intérêts business du Big Data

Il va sans dire qu’il ne servirait à rien d’évoquer cela s’il n’y avait pas d’intérêts potentiels pour les entreprises. Ces nouvelles architectures ouvrent en effet la voie vers de nouveaux horizons jusque là inexplorés.

Pour illustrer ces nouveaux potentiels dans chaque domaine métier de l’entreprise voici, par exemple, quelques cas d’emplois :

• Dans le domaine du CRM : segmentation attitudinale en exploitant les goûts et sentiments des clients/prospects récoltés sur les réseaux sociaux.

• Dans le domaine du Marketing : analyses de tendances permettant d’optimiser les chances d’introduction de nouveaux produits.

• Dans le domaine de la Finance : contrôle en temps réel des transactions frauduleuses ou à risques.

• Dans le domaine des Ressources Humaines : exploitation des données LinkedIn (par exemple) pour anticiper la volonté de départ d’un collaborateur clé.

• Dans le domaine de la Logistique : optimisation des flux de transport en temps réel en fonction du trafic routier.

Les nouvelles possibilités introduites par ces nouvelles architectures sont quasi-infinies !

En conclusion, le Big Data apporte un bol d’oxygène à la Business Intelligence et va pouvoir replacer la Business Intelligence sur le plan stratégique des entreprises. L’analyse de ces données dites « Big Data » va ouvrir la route vers de nouvelles prises de décision et comme le disait fort bien Bill Gates : «How you gather, manage and use information will determine whether you win or lose ». Pensez-y ☺

Pour illustrer ces nouveaux potentiels dans chaque domaine métier de l’entreprise voici, par exemple, quelques cas d’emplois :

• Dans le domaine du CRM : segmentation attitudinale en exploitant les goûts et sentiments des clients/prospects récoltés sur les réseaux sociaux.

• Dans le domaine du Marketing : analyses de tendances permettant d’optimiser les chances d’introduction de nouveaux produits.

• Dans le domaine de la Finance : contrôle en temps réel des transactions frauduleuses ou à risques.

• Dans le domaine des Ressources Humaines : exploitation des données LinkedIn (par exemple) pour anticiper la volonté de départ d’un collaborateur clé.

• Dans le domaine de la Logistique : optimisation des flux de transport en temps réel en fonction du trafic routier.

Les nouvelles possibilités introduites par ces nouvelles architectures sont quasi-infinies !

En conclusion, le Big Data apporte un bol d’oxygène à la Business Intelligence et va pouvoir replacer la Business Intelligence sur le plan stratégique des entreprises. L’analyse de ces données dites « Big Data » va ouvrir la route vers de nouvelles prises de décision et comme le disait fort bien Bill Gates : «How you gather, manage and use information will determine whether you win or lose ». Pensez-y ☺

Autres articles

-

Devoteam renforce son partenariat avec Snowflake et devient partenaire « Elite » en EMEA

-

Devoteam et Google Cloud lancent trois solutions d’IA pour révolutionner l'accès à l'information et l'analyse visuelle

-

Vendée Globe : Devoteam soutient Fabrice Amedeo et son projet océanographique de collecte de données

-

Devoteam et Databricks renforcent leur partenariat en EMEA, avec désormais le plus haut niveau de certification « Elite » et des objectifs ambitieux en matière de transformation via la data et l’IA

-

Olivier Mallet rejoint Devoteam pour prendre la tête de son agence IA