Pentaho, société du groupe Hitachi, annonce cinq innovations, dont SQL on Spark, pour aider les entreprises à surmonter la complexité des Big Data, la pénurie de compétences et les défis que pose l'intégration des données dans des environnements complexes. Ces améliorations permettront aux équipes informatiques d’extraire plus rapidement de la valeur des projets Big Data à partir des ressources existantes, grâce à l'élimination du codage manuel, à une sécurité renforcée et à une prise en charge plus étendue de l'écosystème technologique des Big Data.

1. Une intégration Apache Spark renforcée

Pentaho étend son intégration à Spark au sein de sa plateforme afin que les clients qui désirent incorporer cette technologie populaire puissent :

● Accéder plus facilement à Spark : les analystes peuvent désormais interroger et traiter des données Spark via Pentaho Data Integration (PDI) en utilisant SQL on Spark

● Coordonner, planifier, réutiliser et gérer des applications Spark dans les pipelines de données avec davantage de facilité et de flexibilité : l'orchestration de PDI étendue à Spark Streaming, Spark SQL et Spark Machine Learning (Spark MLlib et Spark ML) permet de prendre en charge le nombre croissant de développeurs qui utilisent plusieurs bibliothèques Spark

● Intégrer les applications Spark dans des plus larges processus pilotés par les données, afin d'en tirer pleinement profit : les développeurs bénéficient de l'orchestration par PDI des applications Spark écrites en langage Python

2. Fonctionnalités étendues d'injection de métadonnées

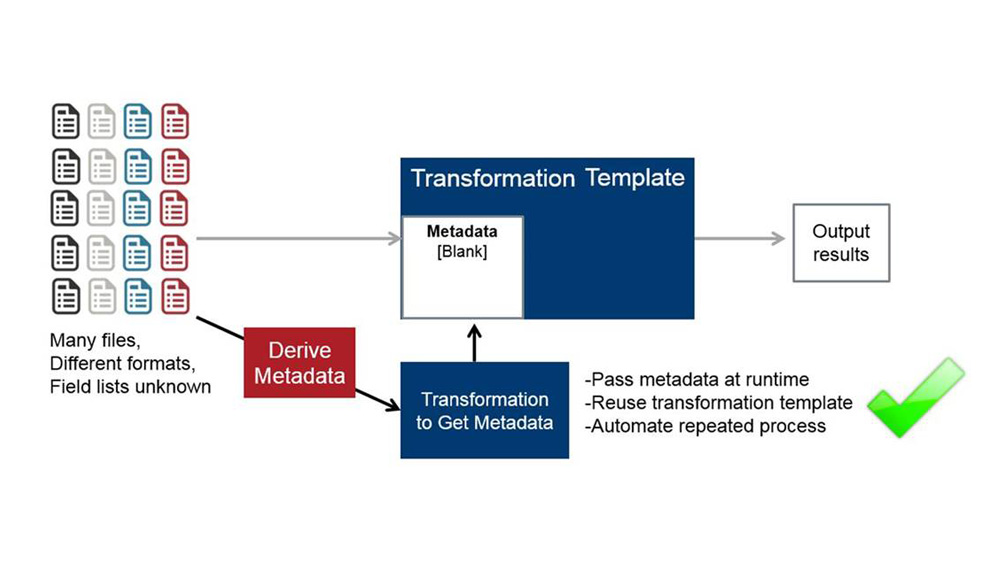

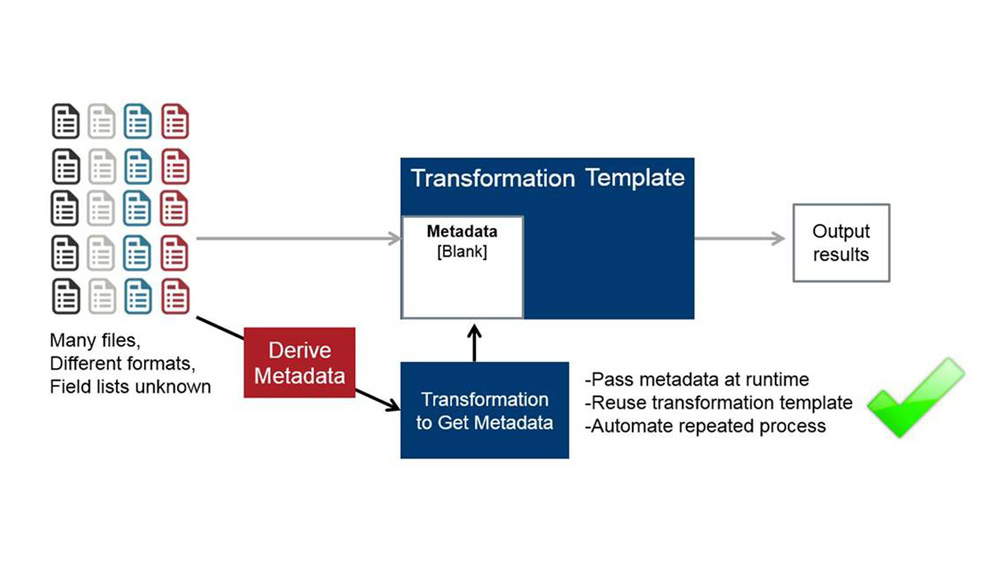

Grâce à la fonctionnalité unique d'injection de métadonnées de Pentaho, permettant d'intégrer plus rapidement différents types de données, les ingénieurs peuvent générer des transformations via PDI de façon dynamique au moment de l'exécution sans devoir coder manuellement chaque source de données. ce qui permet de diviser les coûts par 10. Pentaho ajoute plus de 30 étapes de transformation via PDI compatibles, y compris les opérations liées à Hadoop, Hbase, JSON, XML, Vertica, Greenplum et autres sources Big Data.

3. Intégration étendue de la sécurité des données Hadoop

La sécurisation des environnements Big Data peut s'avérer particulièrement complexe dans la mesure où les technologies qui définissent l'authentification et l'accès ne cessent d'évoluer. Pentaho étend son intégration de la sécurité des données Hadoop pour favoriser la gouvernance des Big Data et ainsi protéger les clusters contre les intrusions. Il s'agit notamment de l'intégration renforcée de Kerberos, pour la sécurisation de l'authentification multi-utilisateur, et de l'intégration de Apache Sentry, pour renforcer les règles qui régissent l'accès à certaines données Hadoop spécifiques.

4. Prise en charge d'Apache Kafka

Apache Kafka, système de messagerie de type publication/abonnement de plus en plus populaire, permet de gérer les grands volumes de données caractéristiques des solutions Big Data et IoT actuelles. Pentaho fournit un support client Entreprise pour envoyer et recevoir des données de Kafka, afin de faciliter le traitement continu des données dans PDI.

5. Prise en charge accrue des formats de fichiers Hadoop

Pentaho prend désormais en charge dans PDI la génération de fichiers Avro et Parquet, deux formats largement utilisés pour le stockage des données dans Hadoop lors de projets d'intégration des Big Data.

« Nos dernières innovations reflètent les efforts continus de Pentaho pour rendre les projets Big Data rapidement opérationnels et rentables en renforçant et en prenant en charge les pipelines de données analytiques, » explique Donna Prlich, Vice-présidente de la gestion de produits, des solutions et du marketing produit chez Pentaho. « Les entreprises peuvent se concentrer sur leurs déploiements Big Data et s’acquitter de la complexité et du temps de préparation des données, en tirant parti de la puissance de nouvelles technologies telles que Spark et Kafka dans l'écosystème Big Data. »

Témoignages clients et partenaires

« Veikkaus, la loterie finlandaise, utilise Pentaho Data Integration pour consolider et traiter rapidement des données relationnelles et semi-structurées, afin d'avoir une meilleure connaissance de ses clients et de les fidéliser, » déclare Harri Räsänen, architecte chez Veikkaus. « Grâce à Pentaho, nous avons pu résoudre rapidement les problèmes liés à la complexité des données et établir un socle de données pérenne dans un environnement Big Data qui ne cesse d'évoluer. »

« Pentaho aide les entreprises à transformer leurs données en avantage concurrentiel en accélérant l'incorporation de technologies telles que Spark dans les environnements de données existants et en gérant les risques pour faciliter l'alignement avec les politiques de sécurité Big Data, » déclare Tim Stevens, vice president of Corporate and Business Development, Cloudera. « Grâce au partenariat entre Cloudera et Pentaho, les clients de ces deux entreprises peuvent mettre plus rapidement sur le marché des applications analytiques Hadoop de pointe. »]

USAble Life of Little Rock, AR, créée en 1993, est une compagnie d'assurance indépendante (vie, invalidité, accident et risques spécifiques). Jason Brannon, superviseur de l'architecture des données chez USAble, déclare « Pour synchroniser les changements continus des informations de souscription entre nos clients et nos partenaires, nous avons

avant tout besoin d'une architecture de données flexible présentant le moins de goulots d'étranglement possible. Le processus d'injection de métadonnées de PDI nous procure une flexibilité sans précédent, car il transforme automatiquement les données clients en informations exploitables pour nos partenaires. Nous pouvons ainsi consacrer tout notre temps à l'analyse des données et à l'amélioration de la relation client. »

North American Bancard Holdings, leader dans le secteur des paiements, traite et analyse plus de 34 milliards de dollars de transactions par an afin d'améliorer ses activités et son service client. Selon Krishna Swargam, architecte Business Intelligence chez North American Bancard Holdings, « Pentaho joue un rôle essentiel dans l'orchestration et l'automatisation de ce pipeline de données. Il fournit des données prêtes pour l'analytique dans un environnement complexe. Et les nouvelles améliorations Big Data de Pentaho vont transformer davantage les activités dans toute l'entreprise. »

1. Une intégration Apache Spark renforcée

Pentaho étend son intégration à Spark au sein de sa plateforme afin que les clients qui désirent incorporer cette technologie populaire puissent :

● Accéder plus facilement à Spark : les analystes peuvent désormais interroger et traiter des données Spark via Pentaho Data Integration (PDI) en utilisant SQL on Spark

● Coordonner, planifier, réutiliser et gérer des applications Spark dans les pipelines de données avec davantage de facilité et de flexibilité : l'orchestration de PDI étendue à Spark Streaming, Spark SQL et Spark Machine Learning (Spark MLlib et Spark ML) permet de prendre en charge le nombre croissant de développeurs qui utilisent plusieurs bibliothèques Spark

● Intégrer les applications Spark dans des plus larges processus pilotés par les données, afin d'en tirer pleinement profit : les développeurs bénéficient de l'orchestration par PDI des applications Spark écrites en langage Python

2. Fonctionnalités étendues d'injection de métadonnées

Grâce à la fonctionnalité unique d'injection de métadonnées de Pentaho, permettant d'intégrer plus rapidement différents types de données, les ingénieurs peuvent générer des transformations via PDI de façon dynamique au moment de l'exécution sans devoir coder manuellement chaque source de données. ce qui permet de diviser les coûts par 10. Pentaho ajoute plus de 30 étapes de transformation via PDI compatibles, y compris les opérations liées à Hadoop, Hbase, JSON, XML, Vertica, Greenplum et autres sources Big Data.

3. Intégration étendue de la sécurité des données Hadoop

La sécurisation des environnements Big Data peut s'avérer particulièrement complexe dans la mesure où les technologies qui définissent l'authentification et l'accès ne cessent d'évoluer. Pentaho étend son intégration de la sécurité des données Hadoop pour favoriser la gouvernance des Big Data et ainsi protéger les clusters contre les intrusions. Il s'agit notamment de l'intégration renforcée de Kerberos, pour la sécurisation de l'authentification multi-utilisateur, et de l'intégration de Apache Sentry, pour renforcer les règles qui régissent l'accès à certaines données Hadoop spécifiques.

4. Prise en charge d'Apache Kafka

Apache Kafka, système de messagerie de type publication/abonnement de plus en plus populaire, permet de gérer les grands volumes de données caractéristiques des solutions Big Data et IoT actuelles. Pentaho fournit un support client Entreprise pour envoyer et recevoir des données de Kafka, afin de faciliter le traitement continu des données dans PDI.

5. Prise en charge accrue des formats de fichiers Hadoop

Pentaho prend désormais en charge dans PDI la génération de fichiers Avro et Parquet, deux formats largement utilisés pour le stockage des données dans Hadoop lors de projets d'intégration des Big Data.

« Nos dernières innovations reflètent les efforts continus de Pentaho pour rendre les projets Big Data rapidement opérationnels et rentables en renforçant et en prenant en charge les pipelines de données analytiques, » explique Donna Prlich, Vice-présidente de la gestion de produits, des solutions et du marketing produit chez Pentaho. « Les entreprises peuvent se concentrer sur leurs déploiements Big Data et s’acquitter de la complexité et du temps de préparation des données, en tirant parti de la puissance de nouvelles technologies telles que Spark et Kafka dans l'écosystème Big Data. »

Témoignages clients et partenaires

« Veikkaus, la loterie finlandaise, utilise Pentaho Data Integration pour consolider et traiter rapidement des données relationnelles et semi-structurées, afin d'avoir une meilleure connaissance de ses clients et de les fidéliser, » déclare Harri Räsänen, architecte chez Veikkaus. « Grâce à Pentaho, nous avons pu résoudre rapidement les problèmes liés à la complexité des données et établir un socle de données pérenne dans un environnement Big Data qui ne cesse d'évoluer. »

« Pentaho aide les entreprises à transformer leurs données en avantage concurrentiel en accélérant l'incorporation de technologies telles que Spark dans les environnements de données existants et en gérant les risques pour faciliter l'alignement avec les politiques de sécurité Big Data, » déclare Tim Stevens, vice president of Corporate and Business Development, Cloudera. « Grâce au partenariat entre Cloudera et Pentaho, les clients de ces deux entreprises peuvent mettre plus rapidement sur le marché des applications analytiques Hadoop de pointe. »]

USAble Life of Little Rock, AR, créée en 1993, est une compagnie d'assurance indépendante (vie, invalidité, accident et risques spécifiques). Jason Brannon, superviseur de l'architecture des données chez USAble, déclare « Pour synchroniser les changements continus des informations de souscription entre nos clients et nos partenaires, nous avons

avant tout besoin d'une architecture de données flexible présentant le moins de goulots d'étranglement possible. Le processus d'injection de métadonnées de PDI nous procure une flexibilité sans précédent, car il transforme automatiquement les données clients en informations exploitables pour nos partenaires. Nous pouvons ainsi consacrer tout notre temps à l'analyse des données et à l'amélioration de la relation client. »

North American Bancard Holdings, leader dans le secteur des paiements, traite et analyse plus de 34 milliards de dollars de transactions par an afin d'améliorer ses activités et son service client. Selon Krishna Swargam, architecte Business Intelligence chez North American Bancard Holdings, « Pentaho joue un rôle essentiel dans l'orchestration et l'automatisation de ce pipeline de données. Il fournit des données prêtes pour l'analytique dans un environnement complexe. Et les nouvelles améliorations Big Data de Pentaho vont transformer davantage les activités dans toute l'entreprise. »

Autres articles

-

Étude Hitachi Vantara – La complexité croissante des infrastructures de données freine la création de valeur de l’IA en Europe

-

Apache Kafka : 15 ans pour réconcilier la technique et le métier

-

Hitachi annonce NVIDIA AI Factory pour accélérer l’innovation en matière d’IA physique

-

Snowflake lance Snowpark Connect pour Apache Spark

-

Hitachi EverFlex AI Data Hub as a Service : une intégration fluide des données au service d’une IA plus intelligente