Microsoft vient d'ouvrir les inscriptions pour l'édition 2010 des TechDays, le grand événement informatique de l'année autour des technologies Microsoft. Pour cette quatrième édition, Microsoft proposera plus de 300 conférences techniques organisées en six grands thèmes :

- Découvertes

- Architecture et développement

- Infrastructure des systèmes d'information

- Efficacité individuelle et collective

- Enjeux

- Rendez-vous décideurs informatiques

Chaque thème se composera de plusieurs parcours parmi lesquels figurera le parcours Décisionnel & Business Intelligence qui réservera un riche contenu aux participants ! Les sept conférences de ce parcours présenteront et illustreront effectivement les nombreuses nouveautés du Décisionnel Microsoft pour l'année 2010 :

- Découverte de Microsoft PowerPivot

- BI for IT

- Les nouveautés de SQL Server Reporting Services 2008 R2

- Business Intelligence avec Microsoft Office 2010

- Accélérez votre Datawarehouse : de Fast Track à SQL Server Parallel Datawarehouse (MPP)

- Microsoft Business Intelligence - Demos Festival

- Enrichir vos applications PowerPivot

Un très beau parcours pour tous les passionnés de Business Intelligence qui souhaitent apporter une véritable valeur ajoutée à tous les décideurs !

D'autres conférences en lien avec ce parcours seront proposées dans le cadre du thème Efficacité individuelle et collective, sans oublier une question majeure pour les Décideurs informatiques : Faut-il repenser les systèmes décisionnels : Vers la BI en libre service ?

Moi j'y serai, et vous ?

Inscrivez-vous dès maintenant sur le site de l'événement : Microsoft TechDays 2010

- Découvertes

- Architecture et développement

- Infrastructure des systèmes d'information

- Efficacité individuelle et collective

- Enjeux

- Rendez-vous décideurs informatiques

Chaque thème se composera de plusieurs parcours parmi lesquels figurera le parcours Décisionnel & Business Intelligence qui réservera un riche contenu aux participants ! Les sept conférences de ce parcours présenteront et illustreront effectivement les nombreuses nouveautés du Décisionnel Microsoft pour l'année 2010 :

- Découverte de Microsoft PowerPivot

- BI for IT

- Les nouveautés de SQL Server Reporting Services 2008 R2

- Business Intelligence avec Microsoft Office 2010

- Accélérez votre Datawarehouse : de Fast Track à SQL Server Parallel Datawarehouse (MPP)

- Microsoft Business Intelligence - Demos Festival

- Enrichir vos applications PowerPivot

Un très beau parcours pour tous les passionnés de Business Intelligence qui souhaitent apporter une véritable valeur ajoutée à tous les décideurs !

D'autres conférences en lien avec ce parcours seront proposées dans le cadre du thème Efficacité individuelle et collective, sans oublier une question majeure pour les Décideurs informatiques : Faut-il repenser les systèmes décisionnels : Vers la BI en libre service ?

Moi j'y serai, et vous ?

Inscrivez-vous dès maintenant sur le site de l'événement : Microsoft TechDays 2010

Rédigé par Claude-Olivier Fontaine le Mercredi 16 Décembre 2009 à 06:26

Dans le cadre de discussions ou conférences sur le thème de la gestion de la performance, vous avez très probablement entendu parler de dashboards et scorecards, deux expressions qui font référence à la notion de tableau de bord. Ces termes sont parfois utilisés de façon interchangeable, bien qu'il existe des différences entre les deux. Quelles sont-elles ?

Nous pouvons définir un dashboard comme une représentation visuelle d'un ensemble d'informations nécessaires à la réalisation d'un ou plusieurs objectifs. Concrètement, un dashboard se matérialise par un écran unique qui permet de suivre l'information en un seul coup d'œil. Cette information peut être fournies sous de multiples formes :

- Un indicateur clé de performance (KPI - Key Performance Indicator) accompagné d'une flèche de tendance;

- Un tableau croisé dynamique représentant les produits les plus vendus;

- Une ligne de tendance qui permet de suivre l'évolution des stocks;

- Une carte utilisant des codes-couleurs en fonction des performances des ventes;

- Un diagramme, une jauge ou un graphique.

Techniquement, un dashboard inclut plusieurs sources de données et doit idéalement permettre à l'utilisateur de construire ses tableaux de bord, basés sur les informations propres à son métier. Les utilisateurs de dashboards évoluent généralement au niveau tactique (planification, gestion de projets, définition de méthodes et procédures) ou opérationnel (exécution) au sein de leur organisation. Par exemple, un manager utilise des dashboards pour mener à bien un projet tactique tel qu'une campagne marketing ou pour suivre la performance des ventes d'un nouveau produit récemment lancé sur le marché. Les dashboards permettent ainsi aux managers d'évaluer la performance opérationnelle sur une base hebdomadaire, quotidienne, et parfois en temps réel.

Contrairement à un dashboard qui présente de multiples informations de différentes façons, un scorecard se focalise sur une métrique donnée et compare celle-ci avec une prévision ou une cible. Un scorecard se construit selon une approche méthodologique qui permet d'aligner l'organisation avec la stratégie. La Balanced Scorecard, qui se base sur quatre perspectives clés (les clients, la finance, les processus internes, et le développement organisationnel), est sans aucun doute la méthodologie la plus connue au niveau international. Les scorecards sont alors utilisés par les Directeurs pour mettre en place une démarche d'alignement et assurer le succès des objectifs stratégiques. Je vous propose de consulter l'article Notion de Corporate Performance Management pour en savoir plus sur la Balanced Scorecard (BSC).

Qu'est-ce qu'un dashboard ?

Nous pouvons définir un dashboard comme une représentation visuelle d'un ensemble d'informations nécessaires à la réalisation d'un ou plusieurs objectifs. Concrètement, un dashboard se matérialise par un écran unique qui permet de suivre l'information en un seul coup d'œil. Cette information peut être fournies sous de multiples formes :

- Un indicateur clé de performance (KPI - Key Performance Indicator) accompagné d'une flèche de tendance;

- Un tableau croisé dynamique représentant les produits les plus vendus;

- Une ligne de tendance qui permet de suivre l'évolution des stocks;

- Une carte utilisant des codes-couleurs en fonction des performances des ventes;

- Un diagramme, une jauge ou un graphique.

Techniquement, un dashboard inclut plusieurs sources de données et doit idéalement permettre à l'utilisateur de construire ses tableaux de bord, basés sur les informations propres à son métier. Les utilisateurs de dashboards évoluent généralement au niveau tactique (planification, gestion de projets, définition de méthodes et procédures) ou opérationnel (exécution) au sein de leur organisation. Par exemple, un manager utilise des dashboards pour mener à bien un projet tactique tel qu'une campagne marketing ou pour suivre la performance des ventes d'un nouveau produit récemment lancé sur le marché. Les dashboards permettent ainsi aux managers d'évaluer la performance opérationnelle sur une base hebdomadaire, quotidienne, et parfois en temps réel.

Qu'est-ce qu'un scorecard ?

Contrairement à un dashboard qui présente de multiples informations de différentes façons, un scorecard se focalise sur une métrique donnée et compare celle-ci avec une prévision ou une cible. Un scorecard se construit selon une approche méthodologique qui permet d'aligner l'organisation avec la stratégie. La Balanced Scorecard, qui se base sur quatre perspectives clés (les clients, la finance, les processus internes, et le développement organisationnel), est sans aucun doute la méthodologie la plus connue au niveau international. Les scorecards sont alors utilisés par les Directeurs pour mettre en place une démarche d'alignement et assurer le succès des objectifs stratégiques. Je vous propose de consulter l'article Notion de Corporate Performance Management pour en savoir plus sur la Balanced Scorecard (BSC).

Rédigé par Claude-Olivier Fontaine le Lundi 30 Novembre 2009 à 08:37

An investment in knowledge always pays the best interest, Benjamin Franklin.

Parce que le business évolue rapidement, parce qu'on ne peut comprendre un monde complexe qu'en se construisant une large culture, parce que de fortes compétences accompagnées de solides connaissances procurent toujours les meilleurs résultats, je vous propose ici quelques ouvrages riches en informations de qualité et retours d'expériences.

Depuis 2005 - époque à laquelle je découvrais la gestion des systèmes d'information - ces lectures me permettent de consolider mes expériences du terrain, d'anticiper, d'épanouir ma réflexion et de construire mes propres approches dans le cadre de mes missions.

Je compléterai cet article au fur et à mesure de mes nouvelles découvertes. Je vous invite à me laisser un commentaire si vous souhaitez que je développe un retour personnel sur l'un de ces ouvrages.

Remarques : ces ouvrages sont tous disponibles sur Amazon.fr ou Amazon.com.

Parce que le business évolue rapidement, parce qu'on ne peut comprendre un monde complexe qu'en se construisant une large culture, parce que de fortes compétences accompagnées de solides connaissances procurent toujours les meilleurs résultats, je vous propose ici quelques ouvrages riches en informations de qualité et retours d'expériences.

Depuis 2005 - époque à laquelle je découvrais la gestion des systèmes d'information - ces lectures me permettent de consolider mes expériences du terrain, d'anticiper, d'épanouir ma réflexion et de construire mes propres approches dans le cadre de mes missions.

Je compléterai cet article au fur et à mesure de mes nouvelles découvertes. Je vous invite à me laisser un commentaire si vous souhaitez que je développe un retour personnel sur l'un de ces ouvrages.

Remarques : ces ouvrages sont tous disponibles sur Amazon.fr ou Amazon.com.

Rédigé par Claude-Olivier Fontaine le Samedi 21 Novembre 2009 à 07:10

Dans le cadre d'une récente discussion avec un responsable appartenant au monde du décisionnel, je me suis une nouvelle fois rendu compte à quel point la notion de CPM - Corporate Performance Management (Gestion de la performance d'entreprise) - est généralement mal appréhendée. Ce domaine est souvent perçu comme une approche orientée systèmes d'information (Business Intelligence, Reporting, intégration...) ou restreint à la gestion de la performance financière. Bien que la réalisation d'une démarche CPM mette à un moment en scène ces éléments, il s'agit d'une vision erronée dans un cas comme dans l'autre. Voici pourquoi, sous la forme d'une brève vue d'ensemble du domaine.

Fondamentalement, le CPM est une démarche qui apporte une réponse à l'échec des entreprises dans l'implémentation de leur stratégie (1). La démarche se fonde sur une organisation, des programmes d'amélioration de la performance et un certain nombre de bonnes pratiques (2).

L'objectif du CPM est de progressivement lever les grandes barrières qui constituent un obstacle à l'implémentation de la stratégie :

- La Vision : une minorité d'opérationnels connaît la stratégie de son entreprise;

- Les Individus : les récompenses issues des activités du management sont très souvent déconnectées de la stratégie d'entreprise;

- Les Ressources : l'organisation ne fait pas suffisamment le lien entre la stratégie et les budgets;

- Le Management : trop peu de temps est accordé aux discussions stratégiques;

En partant de ce constat, le CPM propose aux dirigeants une approche globale qui leur permet de mettre en place une gestion pérenne de la performance de leur organisation.

Une démarche globale et pérenne n'est jamais simple à mettre en œuvre. Une approche CPM nécessite en tout premier lieu la formation d'une équipe senior expérimentée dans le domaine de la gestion du changement. Il s'agit d'une petite équipe - constituée de 5 à 10 personnes - qui intervient à temps complet au sein d'une entité dédiée à la gestion de la performance d'entreprise.

Afin de récolter tous les bénéfices de la démarche et éviter les écueils, les membres de l'équipe doivent être de vrais professionnels de la gestion de la performance et posséder une forte capacité de leadership afin d'être en mesure :

- D'influencer au même moment un grand nombre d'employés;

- De mobiliser ces employés et gérer des équipes virtuelles dans le cadre de la mise en place de programmes et méthodes (Balanced Scorecard, PDCA, Lean, Six Sigma);

- D'intervenir horizontalement et verticalement au sein de l'organisation.

Ce n'est pas tout, les membres de l'équipe CPM doivent également faire preuve d'une forte capacité d'ouverture face à de nouvelles approches et d'une faculté à rationaliser, intégrer et adapter des méthodes. Enfin, au moins un membre de l'équipe doit avoir une forte connaissance d'un secteur spécifique afin d'aider à la résolution de certaines problématiques.

L'alignement constitue le cœur d'une démarche CPM. La notion d'alignement représente la capacité à transformer les objectifs stratégiques de l'entreprise en objectifs opérationnels mesurables pour l'ensemble des employés. Par exemple, Développer l'offre de service représente un objectif stratégique. Au niveau opérationnel, cet objectif se traduit par la définition d'une mesure qui pourrait être le Chiffre d'affaires généré par les nouvelles offres et d'une cible fixé à 20 millions d'euros par exemple. Pour aller un peu plus loin, je vous propose un exemple d'alignement des systèmes de pilotage réalisé par Patrick Jaulent.

Historiquement, le concept d'alignement est issu des travaux de Robert S. Kaplan et David P. Norton. Les notions de Carte Stratégique (ou diagramme causes-et-effets) et Balanced Scorecard constituent deux résultats majeurs que l'on retrouve dans une démarche CPM.

Une Carte Stratégique, c'est un document d'une page qui représente la stratégie de l'entreprise. De la même façon qu'un rapport financier permet à un investisseur de connaître les résultats financiers de l'entreprise, la Carte Stratégique permet à ce même investisseur de comprendre la vision stratégique de l'entreprise. La Carte Stratégique, c'est également l'élément de base qui permet à un employé de bien cerner la stratégie de son entreprise en moins d'une demi-heure et de positionner sa contribution à la réalisation de la stratégie.

La méthodologie de Kaplan et Norton définit la Carte Stratégique selon quatre perspectives :

1. La perspective financière : qu'est-ce qui constitue de la valeur pour les actionnaires de notre entreprise ? Qu'attendent-ils de nous ?

2. La perspective client : quelle est notre segmentation de clients ? Qu'attendent-ils de nous et quelle est notre proposition de valeur ?

3. La perspective processus internes : quels sont les processus clés sur lesquels nous devons exceller afin de délivrer de la valeur aux clients ?

4. La perspective développement organisationnel : quels facteurs de base (les individus, les compétences, la culture, les technologies de l'information) devons-nous mettre en place pour réaliser notre stratégie ?

Une fois les objectifs stratégiques définis, le Balanced Scorecard permet de décliner ces derniers au niveau opérationnel : sur quels axes les employés doivent-ils se concentrer et quelles sont les cibles à atteindre ? Le Balanced Scorecard est alors un outil d'aide à l'exécution de la stratégie.

Grâce au Balanced Scorecard, il est possible de détecter des faiblesses - matérialisées par des mesures qui n'atteignent par leurs cibles - telles qu'une mauvaise satisfaction client ou des cycles de développement trop long. Pour identifier les sources d'erreurs et engager les actions de correction qui permettront de rendre plus efficient les processus clés, une démarche CPM intègre des méthodes fondées sur le principe de l'amélioration continue (Six Sigma, Lean). Le CPM associe ces méthodes à un certain nombre de bonnes pratiques indispensables à une démarche efficace d'amélioration de la performance :

- Identifier et classer par ordre de priorité les projets stratégiques et opérationnels les plus significatifs en termes de changement;

- Mettre en place des processus (groupes de travail, centres d'appels, sondage, intelligence compétitive, etc.) qui permettent de comprendre et réajuster les processus liés à l'évolution des besoins des clients;

- Mettre en place des méthodes comparatives (benchmarking) afin d'améliorer les processus clés et de support;

- Créer une communauté virtuelle de praticiens pour diffuser et optimiser la culture de la performance à l'échelle de l'entreprise.

Risque de perte des savoir-faire et connaissances dû aux départs en retraite, perte de productivité pour cause d'informations introuvables, accès difficile aux données, la gestion des connaissances est incontestablement devenue une problématique cruciale pour toute organisation. Pour répondre à cet enjeu, le CPM intègre plusieurs bonnes pratiques autour de la notion de Knowledge Management (KM). Une démarche de KM a pour objectif de mettre en place l'ensemble des processus qui permettront de gérer et développer l'intelligence organisationnelle. Avec l'émergence des nouvelles technologies, le KM s'est fortement développé sous la forme d'Intranet, portails d'entreprise ou applications Internet qui permettent d'organiser les données et d'améliorer l'accès à celles-ci. Les technologies permettent non seulement d'optimiser le capital humain mais elles constituent également un support aux objectifs d'amélioration de la performance.

D'après ce qui vient d'être vu, la notion de CPM correspond donc à une démarche d'alignement qui intègre l'organisation, les méthodes et l'ensemble des bonnes pratiques indispensables à une exécution de la stratégie réussie.

Si vous souhaitez échanger autour d'une notion évoquée dans cet article ou simplement émettre une remarque, n'hésitez pas à laisser un commentaire.

Corporate Performance Management = stratégie et organisation

Fondamentalement, le CPM est une démarche qui apporte une réponse à l'échec des entreprises dans l'implémentation de leur stratégie (1). La démarche se fonde sur une organisation, des programmes d'amélioration de la performance et un certain nombre de bonnes pratiques (2).

L'objectif du CPM est de progressivement lever les grandes barrières qui constituent un obstacle à l'implémentation de la stratégie :

- La Vision : une minorité d'opérationnels connaît la stratégie de son entreprise;

- Les Individus : les récompenses issues des activités du management sont très souvent déconnectées de la stratégie d'entreprise;

- Les Ressources : l'organisation ne fait pas suffisamment le lien entre la stratégie et les budgets;

- Le Management : trop peu de temps est accordé aux discussions stratégiques;

En partant de ce constat, le CPM propose aux dirigeants une approche globale qui leur permet de mettre en place une gestion pérenne de la performance de leur organisation.

Comment ?

Une démarche globale et pérenne n'est jamais simple à mettre en œuvre. Une approche CPM nécessite en tout premier lieu la formation d'une équipe senior expérimentée dans le domaine de la gestion du changement. Il s'agit d'une petite équipe - constituée de 5 à 10 personnes - qui intervient à temps complet au sein d'une entité dédiée à la gestion de la performance d'entreprise.

Quel est le profil des membres de l'équipe ?

Afin de récolter tous les bénéfices de la démarche et éviter les écueils, les membres de l'équipe doivent être de vrais professionnels de la gestion de la performance et posséder une forte capacité de leadership afin d'être en mesure :

- D'influencer au même moment un grand nombre d'employés;

- De mobiliser ces employés et gérer des équipes virtuelles dans le cadre de la mise en place de programmes et méthodes (Balanced Scorecard, PDCA, Lean, Six Sigma);

- D'intervenir horizontalement et verticalement au sein de l'organisation.

Ce n'est pas tout, les membres de l'équipe CPM doivent également faire preuve d'une forte capacité d'ouverture face à de nouvelles approches et d'une faculté à rationaliser, intégrer et adapter des méthodes. Enfin, au moins un membre de l'équipe doit avoir une forte connaissance d'un secteur spécifique afin d'aider à la résolution de certaines problématiques.

Une démarche d'alignement

L'alignement constitue le cœur d'une démarche CPM. La notion d'alignement représente la capacité à transformer les objectifs stratégiques de l'entreprise en objectifs opérationnels mesurables pour l'ensemble des employés. Par exemple, Développer l'offre de service représente un objectif stratégique. Au niveau opérationnel, cet objectif se traduit par la définition d'une mesure qui pourrait être le Chiffre d'affaires généré par les nouvelles offres et d'une cible fixé à 20 millions d'euros par exemple. Pour aller un peu plus loin, je vous propose un exemple d'alignement des systèmes de pilotage réalisé par Patrick Jaulent.

Historiquement, le concept d'alignement est issu des travaux de Robert S. Kaplan et David P. Norton. Les notions de Carte Stratégique (ou diagramme causes-et-effets) et Balanced Scorecard constituent deux résultats majeurs que l'on retrouve dans une démarche CPM.

Une Carte Stratégique, c'est un document d'une page qui représente la stratégie de l'entreprise. De la même façon qu'un rapport financier permet à un investisseur de connaître les résultats financiers de l'entreprise, la Carte Stratégique permet à ce même investisseur de comprendre la vision stratégique de l'entreprise. La Carte Stratégique, c'est également l'élément de base qui permet à un employé de bien cerner la stratégie de son entreprise en moins d'une demi-heure et de positionner sa contribution à la réalisation de la stratégie.

La méthodologie de Kaplan et Norton définit la Carte Stratégique selon quatre perspectives :

1. La perspective financière : qu'est-ce qui constitue de la valeur pour les actionnaires de notre entreprise ? Qu'attendent-ils de nous ?

2. La perspective client : quelle est notre segmentation de clients ? Qu'attendent-ils de nous et quelle est notre proposition de valeur ?

3. La perspective processus internes : quels sont les processus clés sur lesquels nous devons exceller afin de délivrer de la valeur aux clients ?

4. La perspective développement organisationnel : quels facteurs de base (les individus, les compétences, la culture, les technologies de l'information) devons-nous mettre en place pour réaliser notre stratégie ?

Une fois les objectifs stratégiques définis, le Balanced Scorecard permet de décliner ces derniers au niveau opérationnel : sur quels axes les employés doivent-ils se concentrer et quelles sont les cibles à atteindre ? Le Balanced Scorecard est alors un outil d'aide à l'exécution de la stratégie.

Améliorer la performance

Grâce au Balanced Scorecard, il est possible de détecter des faiblesses - matérialisées par des mesures qui n'atteignent par leurs cibles - telles qu'une mauvaise satisfaction client ou des cycles de développement trop long. Pour identifier les sources d'erreurs et engager les actions de correction qui permettront de rendre plus efficient les processus clés, une démarche CPM intègre des méthodes fondées sur le principe de l'amélioration continue (Six Sigma, Lean). Le CPM associe ces méthodes à un certain nombre de bonnes pratiques indispensables à une démarche efficace d'amélioration de la performance :

- Identifier et classer par ordre de priorité les projets stratégiques et opérationnels les plus significatifs en termes de changement;

- Mettre en place des processus (groupes de travail, centres d'appels, sondage, intelligence compétitive, etc.) qui permettent de comprendre et réajuster les processus liés à l'évolution des besoins des clients;

- Mettre en place des méthodes comparatives (benchmarking) afin d'améliorer les processus clés et de support;

- Créer une communauté virtuelle de praticiens pour diffuser et optimiser la culture de la performance à l'échelle de l'entreprise.

Gérer et développer les connaissances

Risque de perte des savoir-faire et connaissances dû aux départs en retraite, perte de productivité pour cause d'informations introuvables, accès difficile aux données, la gestion des connaissances est incontestablement devenue une problématique cruciale pour toute organisation. Pour répondre à cet enjeu, le CPM intègre plusieurs bonnes pratiques autour de la notion de Knowledge Management (KM). Une démarche de KM a pour objectif de mettre en place l'ensemble des processus qui permettront de gérer et développer l'intelligence organisationnelle. Avec l'émergence des nouvelles technologies, le KM s'est fortement développé sous la forme d'Intranet, portails d'entreprise ou applications Internet qui permettent d'organiser les données et d'améliorer l'accès à celles-ci. Les technologies permettent non seulement d'optimiser le capital humain mais elles constituent également un support aux objectifs d'amélioration de la performance.

En résumé

D'après ce qui vient d'être vu, la notion de CPM correspond donc à une démarche d'alignement qui intègre l'organisation, les méthodes et l'ensemble des bonnes pratiques indispensables à une exécution de la stratégie réussie.

Si vous souhaitez échanger autour d'une notion évoquée dans cet article ou simplement émettre une remarque, n'hésitez pas à laisser un commentaire.

| (1) 90 % des entreprises ne parviennent pas à exécuter leur stratégie (David P. Norton). (2) Plusieurs prix récompensent les entreprises qui ont réussi à implémenter leur stratégie et à démontrer des améliorations dans plusieurs domaines clés (relation client, leadership, gestion de la connaissance, planification stratégique, etc.). Voici quelques prix connus : Balanced Scorecard Hall of Fame (le Ministère Français de la Défense s'est distingué en 2008) Malcom Baldrige National Quality Award Deming Quality Award American Quality and Productivity Center Award Governor's Sterling Award European Foundation for Quality Management Quelques définitions Balanced Scorecard : outil de gestion qui fournit une aide à l'exécution de la stratégie d'entreprise. Il permet de faire le lien entre les objectifs stratégiques de l'entreprise et les objectifs concrets à réaliser au niveau opérationnel. Cycle PDCA (Plan Do Check Act) : modèle qui fournit un support à l'amélioration continue des processus clés de l'entreprise et de son développement organisationnel. Lean (ou Lean Manufacturing) : méthodologie basée sur le principe de l'amélioration continue qui a pour but d'optimiser la création de valeur et de minimiser le gaspillage des ressources. Six Sigma : processus d'amélioration de la qualité des produits et services dont l'objectif est de réduire le nombre d'éléments défectueux issus d'un processus de production. Intérêts de la démarche : améliorer la satisfaction client, améliorer la productivité et instaurer une culture de la qualité au sein de l'organisation. Un ouvrage de référence Five Key Principles of Corporate Performance Management, Bob Paladino Une référence indispensable pour parfaitement bien cerner les enjeux du Corporate Performance Management. L'auteur propose un riche retour d'expérience autour d'un grand nombre d'études de cas issues de différents secteurs d'activités (Santé, Technologies, Finance, Énergie, Transport...). |

Rédigé par Claude-Olivier Fontaine le Lundi 2 Novembre 2009 à 00:09

Le 22 octobre prochain se tiendra à Paris l'édition 2009 de l'Information Management Forum.

Il s'agit d'un événement destiné en priorité aux entreprises utilisatrices qui permettra aux participants d'échanger sur le thème de la gestion de l'information numérique : collecte des données, intégration, gouvernance, qualité, restitution, archivage, gestion des référentiels...

La matinée se déroulera sous la forme d'une session plénière qui permettra à divers intervenants d'exposer leurs retours d'expérience. L'après-midi sera consacrée à des ateliers pratiques proposés par les sponsors de l'événement.

L'agenda complet de l'événement

Le formulaire d'inscription

Il s'agit d'un événement destiné en priorité aux entreprises utilisatrices qui permettra aux participants d'échanger sur le thème de la gestion de l'information numérique : collecte des données, intégration, gouvernance, qualité, restitution, archivage, gestion des référentiels...

La matinée se déroulera sous la forme d'une session plénière qui permettra à divers intervenants d'exposer leurs retours d'expérience. L'après-midi sera consacrée à des ateliers pratiques proposés par les sponsors de l'événement.

L'agenda complet de l'événement

Le formulaire d'inscription

Rédigé par Claude-Olivier Fontaine le Lundi 28 Septembre 2009 à 06:08

Le jeudi 15 Octobre 2009, Tibco organisera un événement autour de son nouvel outil décisionnel TIBCO iProcess Spotfire. L'outil complète la plateforme BPM de l'éditeur en offrant aux utilisateurs une plus grande visibilité des processus métiers automatisés grâce à la création de rapports analytiques personnalisés.

Présentation de L'événement

L'association BPM et BI : le pilotage du BPM

Jeudi 15 octobre, à partir de 8h30

TIBCO iProcess Spotfire, l'informatique décisionnelle in-memory combinée au BPM

Les entreprises utilisent le BPM pour modéliser et automatiser leurs processus métier. Enrichir cette démarche exige une visibilité maximale sur la performance et le comportement de ces processus, et d'aller au-delà de tableaux de bord prédéfinis, basés sur des données statiques. Dans cette optique de pilotage, TIBCO Software renforce sa plate-forme BPM d'une solution de business intelligence : TIBCO iProcess Spotfire.

Le jeudi 15 octobre, TIBCO Software vous invite à découvrir TIBCO iProcess Spotfire, nouvelle dimension de sa plate-forme de gestion des processus métier qui permet de :

- Générer des tableaux de bord et des analyses personnalisés sans faire appel au département informatique

- Disposer d'un outil in-memory qui délivre une information temps réel et une introspection en profondeur des processus pour une analyse des causes à effet

- Bénéficier d'indicateurs issus de données BPM associées aux données applicatives (CRM, ERP...)

- Comprendre le déroulement des processus métier et résoudre rapidement des dysfonctionnements - Optimiser les processus, les ressources et les systèmes associés

Le formulaire d'inscription

Fiche produit de Tibco iProcess Spotfire

Présentation de Tibco iProcess Spotfire

Spotfire dans le cadran magique de Gartner (Magic Quadrant for Business Intelligence Platforms 2009)

Présentation de L'événement

L'association BPM et BI : le pilotage du BPM

Jeudi 15 octobre, à partir de 8h30

TIBCO iProcess Spotfire, l'informatique décisionnelle in-memory combinée au BPM

Les entreprises utilisent le BPM pour modéliser et automatiser leurs processus métier. Enrichir cette démarche exige une visibilité maximale sur la performance et le comportement de ces processus, et d'aller au-delà de tableaux de bord prédéfinis, basés sur des données statiques. Dans cette optique de pilotage, TIBCO Software renforce sa plate-forme BPM d'une solution de business intelligence : TIBCO iProcess Spotfire.

Le jeudi 15 octobre, TIBCO Software vous invite à découvrir TIBCO iProcess Spotfire, nouvelle dimension de sa plate-forme de gestion des processus métier qui permet de :

- Générer des tableaux de bord et des analyses personnalisés sans faire appel au département informatique

- Disposer d'un outil in-memory qui délivre une information temps réel et une introspection en profondeur des processus pour une analyse des causes à effet

- Bénéficier d'indicateurs issus de données BPM associées aux données applicatives (CRM, ERP...)

- Comprendre le déroulement des processus métier et résoudre rapidement des dysfonctionnements - Optimiser les processus, les ressources et les systèmes associés

Le formulaire d'inscription

Fiche produit de Tibco iProcess Spotfire

Présentation de Tibco iProcess Spotfire

Spotfire dans le cadran magique de Gartner (Magic Quadrant for Business Intelligence Platforms 2009)

Rédigé par Claude-Olivier Fontaine le Samedi 19 Septembre 2009 à 23:46

“Over time, the CIO role is less about technology and more about strategy.”, Dave Watt, Director of Business Services, Altagas, Ltd.

L'étude mondiale Global CIO Study réalisée par IBM révèle le nouveau visage des Directeurs des Systèmes d'Information.

Après plus de 2500 interviews, cette étude montre que les DSI doivent marier trois rôles antagonistes en l'apparence mais en fait complémentaires. Ainsi, un DSI est à la fois :

Le point clé à retenir est l'importance du rôle stratégique joué par le DSI. Ce dernier doit être capable de participer à la définition de la stratégie d'entreprise et de répondre aux objectifs des Directions Métiers en réalisant l'alignement du système d'information.

Le résumé de l'étude (en anglais)

Commentaires de l'étude sur ITManager

Articles à venir :

- Les valeurs du Cloud Computing

- Réussir son projet décisionnel

- Excel et Balanced Scorecard

L'étude mondiale Global CIO Study réalisée par IBM révèle le nouveau visage des Directeurs des Systèmes d'Information.

Après plus de 2500 interviews, cette étude montre que les DSI doivent marier trois rôles antagonistes en l'apparence mais en fait complémentaires. Ainsi, un DSI est à la fois :

- Un visionnaire éclairé et un pragmatique efficace

- Un créateur de valeur avisé et un réducteur systématique des coûts

- Un business leader reconnu et un expert IT influent

Le point clé à retenir est l'importance du rôle stratégique joué par le DSI. Ce dernier doit être capable de participer à la définition de la stratégie d'entreprise et de répondre aux objectifs des Directions Métiers en réalisant l'alignement du système d'information.

Le résumé de l'étude (en anglais)

Commentaires de l'étude sur ITManager

Articles à venir :

- Les valeurs du Cloud Computing

- Réussir son projet décisionnel

- Excel et Balanced Scorecard

Rédigé par Claude-Olivier Fontaine le Mercredi 16 Septembre 2009 à 00:18

Le cabinet d'études IDC organisera le jeudi 11 juin 2009 une conférence sur le thème du décisionnel : L'informatique décisionnelle pour vous aider à sortir de la crise... par le haut

L'événement se tiendra dans le premier arrondissement de Paris, aux Salons du Cercle Républicain.

Présentation et objectifs de la conférence

Les logiciels outils et applicatifs décisionnels continuent de représenter un domaine d'investissement important pour les entreprises et les administrations françaises, y compris dans un contexte de crise (+ 5,8% en 2009 selon IDC.) En effet, disposer plus rapidement d'un ensemble d'informations plus large et bénéficier d'un reporting plus fin et de simulations plus précises est précieux lorsqu'il s'agit de prendre des décisions stratégiques pertinentes avec des marges de manœuvre réduites, notamment dans le but de réduire les coûts ou de fidéliser ses clients.

Inscriptions

Tous les acteurs impliqués dans une démarche d'informatique décisionnelle et appartenant à une entreprise utilisatrice peuvent s'inscrire gratuitement sur le site de l'IDC. La conférence est payante pour les sociétés de service.

L'événement se tiendra dans le premier arrondissement de Paris, aux Salons du Cercle Républicain.

Présentation et objectifs de la conférence

Les logiciels outils et applicatifs décisionnels continuent de représenter un domaine d'investissement important pour les entreprises et les administrations françaises, y compris dans un contexte de crise (+ 5,8% en 2009 selon IDC.) En effet, disposer plus rapidement d'un ensemble d'informations plus large et bénéficier d'un reporting plus fin et de simulations plus précises est précieux lorsqu'il s'agit de prendre des décisions stratégiques pertinentes avec des marges de manœuvre réduites, notamment dans le but de réduire les coûts ou de fidéliser ses clients.

- Quelles offres vont profiter de la crise ? Les plate-formes intégrées ? Les outils de "predictive analytics" ? La BI en mode SaaS ? Les offres à forte composante Open Source ? Les offres "self service" ?

- Les alternatives aux produits décisionnels sont-elles toujours viables ?

- La BI accessible aux fonctions départementales et aux moins grandes entreprises : mythe ou réalité ?

- En quoi la redistribution des cartes entre les principaux fournisseurs suite au grand mouvement de consolidation de l'année 2007 change-t-elle aujourd'hui la donne pour les utilisateurs ?

- Pourquoi cette appétence française pour les outils de BI et les applications analytiques financières?

- Quelle ligne de partage demain entre les DSI et les Direction Métiers ?

Inscriptions

Tous les acteurs impliqués dans une démarche d'informatique décisionnelle et appartenant à une entreprise utilisatrice peuvent s'inscrire gratuitement sur le site de l'IDC. La conférence est payante pour les sociétés de service.

Rédigé par Claude-Olivier Fontaine le Mardi 2 Juin 2009 à 21:49

A - C - D - E - F - I - K - M - N - O - S - T

attribut

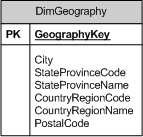

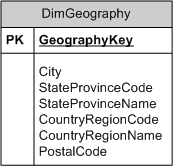

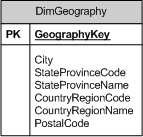

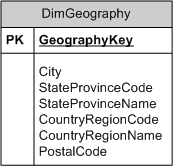

Dans le cadre de la modélisation dimensionnelle, un attribut est un champs qui permet de décrire une table de dimension. Dans l'illustration suivante, City, StateProvinceCode, StateProvinceName, CountryRegionCode, CountryRegionName et PostalCode sont des attributs de la table de dimension DimGeography.

Table de dimension comprenant six attributs

Plus généralement, tous les éléments d'une table de dimension sont des attributs - à l'exception de la clé primaire.

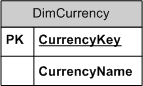

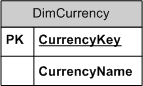

clé primaire

Une clé primaire est une colonne (ou un ensemble de colonnes) d'une table qui identifie chaque ligne de cette table de façon unique. Dans la table de dimension suivante, la clé primaire CurrencyKey permet d'identifier une devise de façon unique.

Table de dimension munie d'une clé primaire

cube

Un cube est un modèle dimensionnel stocké dans une structure multidimensionnelle (OLAP).

dimension

Une dimension est un axe qui permet d'analyser une mesure selon différentes perspectives. Le temps, le produit, le client et la localisation géographique sont des exemples de dimension. Définition connexe : table de dimension.

drill down

L'expression drill down représente la possibilité d'obtenir une vision détaillée d'une donnée.

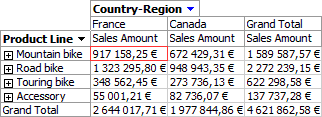

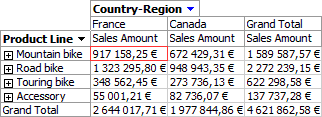

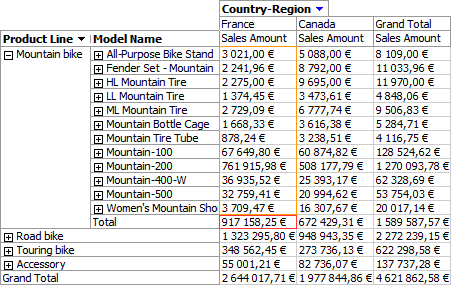

Prenons le cas du rapport suivant qui représente des volumes de ventes (Sales Amount) répartis par gammes de produits (Product Line) et réalisés dans deux pays (France et Canada). L'utilisateur sait par exemple que les ventes de VTT ont généré 917 158, 25 euros en France.

Vue résumée d'un volume de ventes

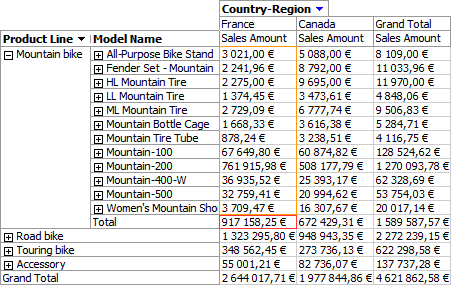

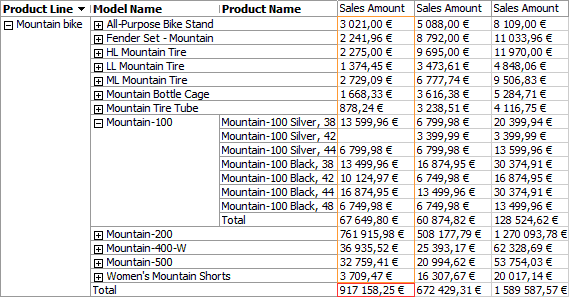

Selon ses responsabilités dans l'organisation, l'utilisateur aura peut-être besoin d'en savoir plus sur ce volume de ventes. Le manager en charge de la gamme VTT, obtiendra une vision détaillée de cette donnée en cliquant sur l'icône associé à Mountain Bike. C'est sur cette action précise que l'utilisateur réalise une opération de drill down qui lui fournit la vue suivante :

associé à Mountain Bike. C'est sur cette action précise que l'utilisateur réalise une opération de drill down qui lui fournit la vue suivante :

Vue détaillée d'un volume de ventes

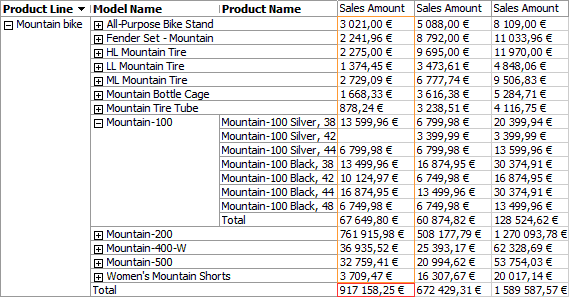

Cette vue fournit, pour la gamme VTT, une répartition du volume de ventes selon les différents modèles de la gamme (HL Mountain Tire, Mountain-100...). Dans cet exemple, on remarque que l'utilisateur a la possibilité d'obtenir des détails supplémentaires avec une répartition du volume de ventes selon les différents produits d'un modèle (Product Name) :

Vue détaillée d'un volume de ventes avec une vision plus fine

En cliquant sur les icônes , l'utilisateur réalise une opération de drill up.

, l'utilisateur réalise une opération de drill up.

drill up

L'expression drill up représente le passage d'une vue détaillée d'une information à une vue résumée de celle-ci. L'opération inverse se nomme drill down.

entrepôt de données

Un entrepôt de données est une base de données qui stocke des données extraites de divers systèmes opérationnels. Un entrepôt de données est un système conçu et optimisé pour les analyses de données.

ERP (Enterprise Resource Planning)

Le sigle ERP désigne un type de système opérationnel dont le but est de supporter tout ou partie des unités opérationnelles (Ressources Humaines, Finance, Production...) d'une entreprise.

ETL (Extract Transform Load)

Le sigle ETL désigne un ensemble de processus qui ont pour rôle d'extraire des données stockées dans divers systèmes opérationnels (Extract), de transformer ces données (Transform) et de les charger dans un entrepôt de données (Load).

Quelques systèmes ETL populaires :

- Genio 7

- IBM InfoSphere DataStage

- Informatica PowerCenter

- Microsoft SQL Server Integration Services (SSIS)

- Oracle Data Integrator

- SAP BusinessObjects Data Integrator

fait

Un fait désigne soit une référence vers une table de dimensions soit une mesure. Les faits sont stockés dans des tables de faits.

informatique décisionnelle

L'expression informatique décisionnelle désigne l'ensemble des technologies, outils et processus qui permet à tout individu d'une organisation d'accéder facilement à des données et de les analyser.

KPI (Key Performance Indicator)

Un KPI (indicateur clé de performance) est une métrique financière ou non-financière qui permet d'évaluer les performances d'une organisation. Le chiffre d'affaire et la satisfaction client (évaluée quantitativement par un score) sont des exemples de KPI.

mesure

Une mesure est une donnée numérique stockée dans une table de faits. Un prix, une quantité et une remise sont des exemples de mesure.

modélisation dimensionnelle

La modélisation dimensionnelle est une technique de conception qui permet de structurer les données de façon à présenter une information intuitive aux utilisateurs et à optimiser la performance des requêtes.

modèle dimensionnel

Un modèle dimensionnel est un modèle de données structuré de façon à optimiser la performance des requêtes et la facilité d'utilisation. Le schéma en étoile est une représentation classique d'un modèle dimensionnel (les deux notions sont souvent synonymes).

MDX

MDX (MultiDimensional eXpressions) est un langage utilisé pour manipuler les données d'une base OLAP. MDX est similaire au langage SQL.

normalisation

La normalisation est une technique de modélisation qui permet de supprimer ou limiter les données redondantes au sein d'une base de données.

OLAP (OnLine Analytical Process)

L'acronyme OLAP désigne un mécanisme qui permet d'analyser des données selon différents niveaux de détails (l'année/le trimestre/le mois, le pays/la région/le département...) et différentes dimensions (le temps, le client, le produit, la localisation géographique...). Expressions usuelles : base de données OLAP, plateforme OLAP, serveur OLAP, architecture OLAP.

Concrètement, OLAP permet par exemple de répondre aux questions suivantes :

- Combien mon entreprise a-t-elle vendu de produits en 2008 dans un pays donné ? Quelle est la tendance par rapport à 2007 ?

- Comment le chiffre d'affaire a-t-il évolué au cours de ces trois dernières années ?

- Quels sont les produits les plus profitables depuis ces six derniers mois ?

OLAP se décline en quatre architectures qui permettent de s'adapter à différentes problématiques de performance et de stockage de données :

- DOLAP (Dynamic OLAP).

- HOLAP (Hybrid OLAP).

- MOLAP (Multidimensional OLAP).

- ROLAP (Relational OLAP).

Quelques solutions OLAP populaires :

- IBM Cognos 8 Business Intelligence

- Microsoft SQL Server Analysis Services (SSAS)

- MicroStrategy 8

- Oracle Essbase

- SAP BusinessObjects Web Intelligence

- SAP NetWeaver

- SAS OLAP Server

Le marché des plateformes d'informatique décisionnelle selon le cabinet Gartner : Magic Quadrant for Business Intelligence Platforms

OLTP (OnLine Transaction Processing)

Le sigle OLTP désigne un mécanisme utilisé par les systèmes opérationnels qui permet le traitement de tâches en temps réel, telles que la saisie d'une nouvelle commande ou l'édition d'un profil client. Expression usuelle : base de données OLTP.

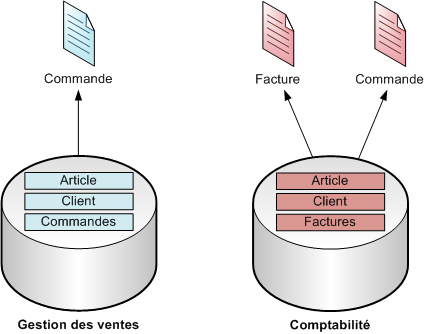

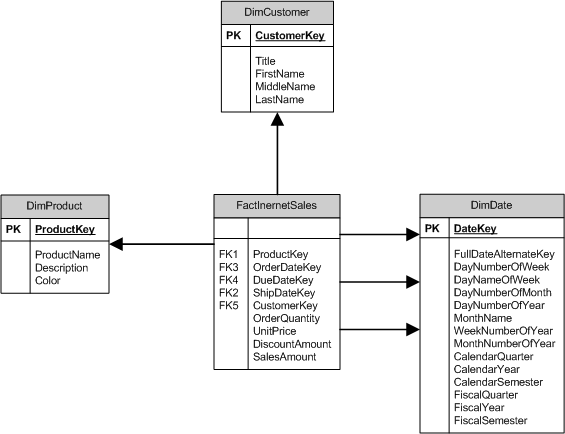

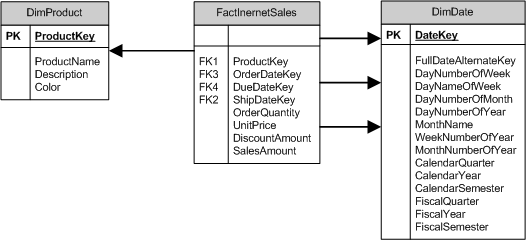

schéma en étoile

Le schéma en étoile est une façon de représenter un modèle dimensionnel au sein d'une base de données relationnelle. Un schéma en étoile se constitue d'une table de faits associée à un ensemble de tables de dimension. Ces dernières sont toujours directement reliées à la table de faits.

Schéma en étoile comprenant une table de faits et trois tables de dimension

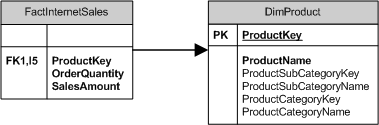

schéma en flocon

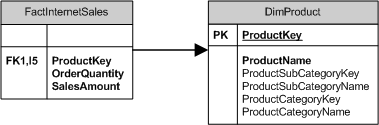

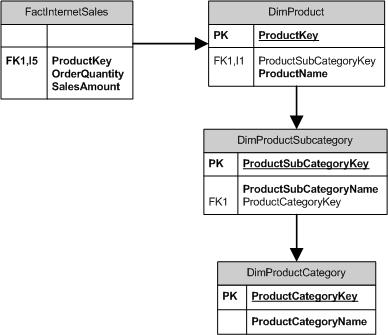

Un schéma en flocon est une représentation normalisée (3NF) d'une unique table de dimension. Cette table, qui peut parfois contenir un grand nombre d'attributs, est scindée en plusieurs entités. Ci-dessous, la Figure 1 représente une dimension Produit sous la forme d'un schéma en étoile et la Figure 2 présente son équivalent sous la forme d'un schéma en flocon.

Figure 1 - Dimension Produit modélisée sous la forme d'un schéma en étoile

Figure 2 - Dimension Produit modélisée sous la forme d'un schéma en flocon (normalisation)

SKU (Stock Keeping Unit)

Un SKU est un code qui permet d'identifier un produit de façon unique. Ce code a pour but de faciliter l'identification d'un produit du point de vue d'un fournisseur.

SQL (Structured Query Language)

Le sigle SQL désigne un langage informatique utilisé pour communiquer avec une base de données relationnelle.

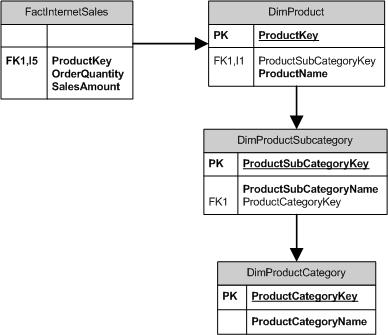

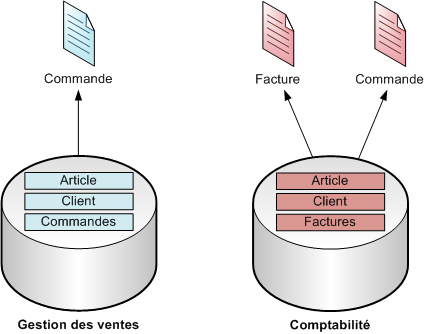

système opérationnel

Un système opérationnel est une base de données dont le rôle est de supporter les activités quotidiennes d'une entreprise.

Exemples :

- La base de données utilisée pour la comptabilité est un système opérationnel.

- La base de données utilisée pour la gestion des ventes est également un système opérationnel.

Systèmes opérationnels pour la Gestion des ventes et la Comptabilité

table de dimension

Une table de dimension est une table constituée d'une clé primaire (définie sur une seule colonne) et d'un ensemble d'attributs. La figure suivante illustre la notion de table de dimension pour une dimension Géographie.

Table de dimension Géographie

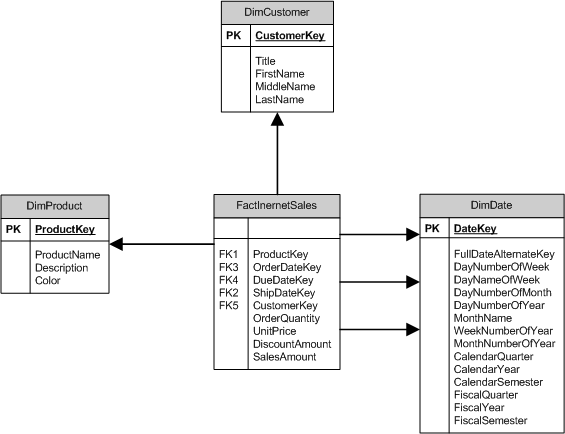

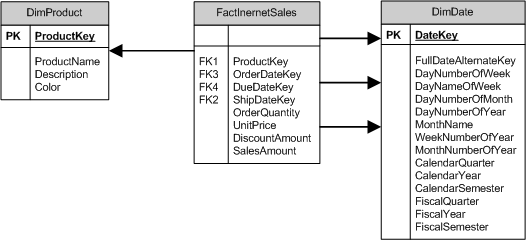

table de faits

Une table de faits est une table constituée de références (clés étrangères) vers des tables de dimension et de valeurs numériques à analyser nommées mesures. Le schéma suivant présente une table de faits nommée FactInternetSales reliée à deux dimensions, DimProduct et DimDate. La table FactInternetSales contient quatre références vers les tables de dimension DimProduct et DimDate (respectivement ProductKey, OrderDateKey, DueDateKey et ShipDateKey) et quatre mesures nommées OrderQuantity, UnitPrice, DiscountAmount et SalesAmount.

Table de faits munie de quatre références et quatre mesures

Date de publication : mardi 10 février 2009

Date de dernière mise à jour : mardi 10 février 2009

A

attribut

Dans le cadre de la modélisation dimensionnelle, un attribut est un champs qui permet de décrire une table de dimension. Dans l'illustration suivante, City, StateProvinceCode, StateProvinceName, CountryRegionCode, CountryRegionName et PostalCode sont des attributs de la table de dimension DimGeography.

Table de dimension comprenant six attributs

Plus généralement, tous les éléments d'une table de dimension sont des attributs - à l'exception de la clé primaire.

C

clé primaire

Une clé primaire est une colonne (ou un ensemble de colonnes) d'une table qui identifie chaque ligne de cette table de façon unique. Dans la table de dimension suivante, la clé primaire CurrencyKey permet d'identifier une devise de façon unique.

Table de dimension munie d'une clé primaire

cube

Un cube est un modèle dimensionnel stocké dans une structure multidimensionnelle (OLAP).

D

dimension

Une dimension est un axe qui permet d'analyser une mesure selon différentes perspectives. Le temps, le produit, le client et la localisation géographique sont des exemples de dimension. Définition connexe : table de dimension.

drill down

L'expression drill down représente la possibilité d'obtenir une vision détaillée d'une donnée.

Prenons le cas du rapport suivant qui représente des volumes de ventes (Sales Amount) répartis par gammes de produits (Product Line) et réalisés dans deux pays (France et Canada). L'utilisateur sait par exemple que les ventes de VTT ont généré 917 158, 25 euros en France.

Vue résumée d'un volume de ventes

Selon ses responsabilités dans l'organisation, l'utilisateur aura peut-être besoin d'en savoir plus sur ce volume de ventes. Le manager en charge de la gamme VTT, obtiendra une vision détaillée de cette donnée en cliquant sur l'icône

Vue détaillée d'un volume de ventes

Cette vue fournit, pour la gamme VTT, une répartition du volume de ventes selon les différents modèles de la gamme (HL Mountain Tire, Mountain-100...). Dans cet exemple, on remarque que l'utilisateur a la possibilité d'obtenir des détails supplémentaires avec une répartition du volume de ventes selon les différents produits d'un modèle (Product Name) :

Vue détaillée d'un volume de ventes avec une vision plus fine

En cliquant sur les icônes

drill up

L'expression drill up représente le passage d'une vue détaillée d'une information à une vue résumée de celle-ci. L'opération inverse se nomme drill down.

E

entrepôt de données

Un entrepôt de données est une base de données qui stocke des données extraites de divers systèmes opérationnels. Un entrepôt de données est un système conçu et optimisé pour les analyses de données.

ERP (Enterprise Resource Planning)

Le sigle ERP désigne un type de système opérationnel dont le but est de supporter tout ou partie des unités opérationnelles (Ressources Humaines, Finance, Production...) d'une entreprise.

ETL (Extract Transform Load)

Le sigle ETL désigne un ensemble de processus qui ont pour rôle d'extraire des données stockées dans divers systèmes opérationnels (Extract), de transformer ces données (Transform) et de les charger dans un entrepôt de données (Load).

Quelques systèmes ETL populaires :

- Genio 7

- IBM InfoSphere DataStage

- Informatica PowerCenter

- Microsoft SQL Server Integration Services (SSIS)

- Oracle Data Integrator

- SAP BusinessObjects Data Integrator

F

fait

Un fait désigne soit une référence vers une table de dimensions soit une mesure. Les faits sont stockés dans des tables de faits.

I

informatique décisionnelle

L'expression informatique décisionnelle désigne l'ensemble des technologies, outils et processus qui permet à tout individu d'une organisation d'accéder facilement à des données et de les analyser.

K

KPI (Key Performance Indicator)

Un KPI (indicateur clé de performance) est une métrique financière ou non-financière qui permet d'évaluer les performances d'une organisation. Le chiffre d'affaire et la satisfaction client (évaluée quantitativement par un score) sont des exemples de KPI.

M

mesure

Une mesure est une donnée numérique stockée dans une table de faits. Un prix, une quantité et une remise sont des exemples de mesure.

modélisation dimensionnelle

La modélisation dimensionnelle est une technique de conception qui permet de structurer les données de façon à présenter une information intuitive aux utilisateurs et à optimiser la performance des requêtes.

modèle dimensionnel

Un modèle dimensionnel est un modèle de données structuré de façon à optimiser la performance des requêtes et la facilité d'utilisation. Le schéma en étoile est une représentation classique d'un modèle dimensionnel (les deux notions sont souvent synonymes).

MDX

MDX (MultiDimensional eXpressions) est un langage utilisé pour manipuler les données d'une base OLAP. MDX est similaire au langage SQL.

N

normalisation

La normalisation est une technique de modélisation qui permet de supprimer ou limiter les données redondantes au sein d'une base de données.

O

OLAP (OnLine Analytical Process)

L'acronyme OLAP désigne un mécanisme qui permet d'analyser des données selon différents niveaux de détails (l'année/le trimestre/le mois, le pays/la région/le département...) et différentes dimensions (le temps, le client, le produit, la localisation géographique...). Expressions usuelles : base de données OLAP, plateforme OLAP, serveur OLAP, architecture OLAP.

Concrètement, OLAP permet par exemple de répondre aux questions suivantes :

- Combien mon entreprise a-t-elle vendu de produits en 2008 dans un pays donné ? Quelle est la tendance par rapport à 2007 ?

- Comment le chiffre d'affaire a-t-il évolué au cours de ces trois dernières années ?

- Quels sont les produits les plus profitables depuis ces six derniers mois ?

OLAP se décline en quatre architectures qui permettent de s'adapter à différentes problématiques de performance et de stockage de données :

- DOLAP (Dynamic OLAP).

- HOLAP (Hybrid OLAP).

- MOLAP (Multidimensional OLAP).

- ROLAP (Relational OLAP).

Quelques solutions OLAP populaires :

- IBM Cognos 8 Business Intelligence

- Microsoft SQL Server Analysis Services (SSAS)

- MicroStrategy 8

- Oracle Essbase

- SAP BusinessObjects Web Intelligence

- SAP NetWeaver

- SAS OLAP Server

Le marché des plateformes d'informatique décisionnelle selon le cabinet Gartner : Magic Quadrant for Business Intelligence Platforms

OLTP (OnLine Transaction Processing)

Le sigle OLTP désigne un mécanisme utilisé par les systèmes opérationnels qui permet le traitement de tâches en temps réel, telles que la saisie d'une nouvelle commande ou l'édition d'un profil client. Expression usuelle : base de données OLTP.

S

schéma en étoile

Le schéma en étoile est une façon de représenter un modèle dimensionnel au sein d'une base de données relationnelle. Un schéma en étoile se constitue d'une table de faits associée à un ensemble de tables de dimension. Ces dernières sont toujours directement reliées à la table de faits.

Schéma en étoile comprenant une table de faits et trois tables de dimension

schéma en flocon

Un schéma en flocon est une représentation normalisée (3NF) d'une unique table de dimension. Cette table, qui peut parfois contenir un grand nombre d'attributs, est scindée en plusieurs entités. Ci-dessous, la Figure 1 représente une dimension Produit sous la forme d'un schéma en étoile et la Figure 2 présente son équivalent sous la forme d'un schéma en flocon.

Figure 1 - Dimension Produit modélisée sous la forme d'un schéma en étoile

Figure 2 - Dimension Produit modélisée sous la forme d'un schéma en flocon (normalisation)

SKU (Stock Keeping Unit)

Un SKU est un code qui permet d'identifier un produit de façon unique. Ce code a pour but de faciliter l'identification d'un produit du point de vue d'un fournisseur.

SQL (Structured Query Language)

Le sigle SQL désigne un langage informatique utilisé pour communiquer avec une base de données relationnelle.

système opérationnel

Un système opérationnel est une base de données dont le rôle est de supporter les activités quotidiennes d'une entreprise.

Exemples :

- La base de données utilisée pour la comptabilité est un système opérationnel.

- La base de données utilisée pour la gestion des ventes est également un système opérationnel.

Systèmes opérationnels pour la Gestion des ventes et la Comptabilité

T

table de dimension

Une table de dimension est une table constituée d'une clé primaire (définie sur une seule colonne) et d'un ensemble d'attributs. La figure suivante illustre la notion de table de dimension pour une dimension Géographie.

Table de dimension Géographie

table de faits

Une table de faits est une table constituée de références (clés étrangères) vers des tables de dimension et de valeurs numériques à analyser nommées mesures. Le schéma suivant présente une table de faits nommée FactInternetSales reliée à deux dimensions, DimProduct et DimDate. La table FactInternetSales contient quatre références vers les tables de dimension DimProduct et DimDate (respectivement ProductKey, OrderDateKey, DueDateKey et ShipDateKey) et quatre mesures nommées OrderQuantity, UnitPrice, DiscountAmount et SalesAmount.

Table de faits munie de quatre références et quatre mesures

Date de publication : mardi 10 février 2009

Date de dernière mise à jour : mardi 10 février 2009

Rédigé par Claude-Olivier Fontaine le Mardi 10 Février 2009 à 06:07

Qu’est-ce que l’Extreme Programming ?

L’Extreme Programming (XP) est un processus agile conçu pour la gestion des projets de développement informatique. L'XP a été proposé par l'ingénieur américain Kent Beck au milieu des années 1990 et représente aujourd’hui l’un des plus célèbres processus agiles.

Qu’est-ce qu’un processus agile ?

Dans le cadre d’XP, la notion de processus recouvre un ensemble d’activités, de bonnes pratiques et de règles dont l’objectif est de mener à bien des développements informatiques. L'XP est qualifié d’agile car il s'appuie sur l'acceptation du changement et sur une réponse rapide à l’évolution des besoins. Cette notion de processus agile est parfois confrontée à d'autres processus qui peuvent être considérés comme un ensemble d'activités trop prescriptives et bureaucratiques. Ce n'est pas l'objet de cette brève présentation mais à ce sujet, il peut être utile de se pencher sur les nombreux débats autour d'XP et du Processus Unifié.

À quoi l'XP aspire-t-il ?

XP est un processus itératif qui se fonde sur la communication, le travail d’équipe et sur la relation client pour répondre aux objectifs suivants :

- Améliorer la satisfaction client.

- Assurer la livraison des logiciels dans les temps.

- Etre capable de répondre aux changements des utilisateurs / clients.

- Livrer un logiciel de qualité.

Comment l'XP s’organise-t-il ?

Pour tenter de répondre aux objectifs précédents, XP s’appuie sur quatre activités principales :

1. La planification

2. Le codage

3. La conception

4. Les tests

Un certain nombre de pratiques et règles composent chacune de ces activités.

L’activité de planification a pour objectif de définir un plan global du projet, ce dernier étant formé d’une dizaine d’itérations de 1 à 3 semaines. Dans les grandes lignes, ce plan prend en compte :

- Les besoins des utilisateurs, qui sont rédigés dans des User Stories. La finalité des User Stories est comparable à celle des Use Cases d’UML.

- Le produit intermédiaire à livrer suite à chaque itération.

- La définition des itérations. A chaque début d’itération, une petite réunion doit permettre d’établir le travail à réaliser et d’intégrer les éventuels changements. C’est seulement à chaque début d’itération que l’équipe décide des tâches qui seront programmées.

- Cette réunion inclut également la révision du planning des itérations. Un changement dans les besoins ou une difficulté inattendue peut bousculer un planning. L'XP prend en compte ces facteurs en se plaçant sous l’hypothèse qu’il n’est pas possible de fixer le travail qui sera réalisée dans deux ou trois itérations. Une vision sage, pragmatique et réaliste, sous certaines conditions.

- La prévision de courtes réunions quotidiennes. Ces réunions sont informelles et peuvent se dérouler debout, à proximité des machines, de façon à impliquer tous les développeurs.

- L’éventuel abandon de règles qui ne fonctionnent pas ou qu’une partie de l’équipe ne comprend pas. Les règles préconisées par l'XP ne doivent en aucun cas constituer un frein au développement du projet.

L’activité de codage comprend les pratiques suivantes :

- La création de tests unitaires. Le test unitaire est l’une des pierres angulaires d’XP. Ces tests doivent être créés et automatisés à l’aide d’outils dédiés aux tests, tels que Visual Studio Team Test ou JUnit. Les tests doivent s’appliquer à toutes les classes de l’application et il est fortement conseillé de les créer en premier, avant le code.

- L’utilisation de standards de codage (meilleures pratiques).

- Le travail en binôme. XP considère que deux développeurs sur une même machine produiront un résultat final de meilleure qualité et auront plus de facilités à intégrer les fonctionnalités du logiciel.

- La phase d’optimisation n’a lieu qu’une fois que l’application finale est terminée.

- Chaque classe peut porter le nom de son créateur afin de faciliter la phase d’intégration et de mise à jour. XP préconise également de faire appel à une équipe d’intégration.

- Les développeurs ne doivent pas faire d’heures supplémentaires (et ce n’est pas une blague !). Le travail supplémentaire mine le moral de l’équipe et ne permet pas de terminer un projet à l’heure.

- Chaque membre de l’équipe doit s’approprier l’ensemble du logiciel en cours de développement. Un développeur créé des morceaux de code qui peuvent être modifiés (correction d’un bug, amélioration d’une idée, ajout d’une fonctionnalité, etc.) par ses collègues.

- Le client ou futur utilisateur du logiciel doit être disponible. Tout au long du processus, l’équipe doit pouvoir communiquer avec le client. En particulier, au début de chaque itération, le client doit pouvoir apporter les détails qui seront nécessaires à la réalisation de l’itération. En fin d’itération, suite à la livraison d’une version intermédiaire du produit, le feedback client est également indispensable.

L’activité de conception prend en compte les pratiques suivantes :

- Privilégier la simplicité à la complexité. Lorsqu’il est possible d’implanter deux solutions, toujours choisir la solution la moins complexe. Une solution simple est toujours moins coûteuse, plus rapide à mettre en place et plus simple à modifier.

- Communiquer avec le monde fonctionnel via l’utilisation de métaphores afin de favoriser la compréhension entre les parties prenantes.

- Ne jamais rajouter des fonctionnalités trop tôt ou qui n’ont pas été exigées par le client. C’est une perte de temps inutile qui bouscule le planning et qui réduit le potentiel de flexibilité.

- Indispensable à la création d’un logiciel de qualité, la réfactorisation du code est une étape qui doit se reproduire tout au long du projet. La réfactorisation consiste à affiner le code déjà créé en éliminant les parties redondantes et fonctionnalités inutilisées, et en retouchant éventuellement certaines parties susceptibles de simplifier l’architecture du logiciel.

Enfin, l’activité de test inclut les règles suivantes :

- Nous l’avons déjà évoqué plus haut, tout morceau de code doit pouvoir être testé.

- Un code qui ne passe pas un test avec succès est un code qui ne doit pas être mis en production.

- La découverte d’un bug entraîne systématiquement la création d’un test visant à le corriger.

- La création de tests fonctionnels créés à partir des spécifications fonctionnelles (les User Stories) représente l’un des fondements d’XP. Ces tests permettent d’impliquer le client dans le projet puisqu’il a la responsabilité de valider l’exactitude des tests fonctionnels. Les tests fournissent-ils le résultat escompté ? Si oui, les résultats sont-ils satisfaisants ? Un User Story ne peut être validé que lorsque ces tests fonctionnels sont satisfaisants pour le client.

La liste des règles et bonnes pratiques peut sembler longue (la list suivante n'est pas exhaustive) mais au final, le processus offre une vision plutôt pragmatique :

1. Le client et l’équipe technique se mettent d’accord sur les grandes lignes du projet à réaliser. La communication est simplifiée via l’usage de métaphores pour définir les différents concepts techniques.

2. Le client et l’équipe technique rédigent les spécifications fonctionnelles (User Stories) de façon non détaillée.

3. L’équipe technique définie un planning pour l’ensemble des itérations, en prenant en compte les User Stories.

4. Le travail de la première itération est défini puis celle-ci est lancée. Le développeur et les utilisateurs communiquent en face-à-face pour obtenir une vision plus fine des User Stories.

5. Les développements, tests et débogages sont réalisés.

6. Une version intermédiaire du produit est livrée au client.

7. Le client contrôle/valide les tests fonctionnels et fournit un feedback sur la version intermédiaire livrée.

8. Quel que soit le résultat, la seconde itération est lancée. Celle-ci se précède d’une réunion qui consiste à valider le travail réalisé, à prendre en compte les difficultés rencontrées et à modifier le planning des itérations si nécessaire.

Les itérations se succèdent jusqu’à ce que le produit final soit livré.

Pour en savoir plus : Extreme Programming Explained : Embrace Change

Claude-Olivier Fontaine

Date de publication : vendredi 23 novembre 2007

Rédigé par Claude-Olivier Fontaine le Vendredi 23 Novembre 2007 à 07:56

> A LIRE EN CE MOMENT SUR DECIDEO

-

L’écart d’exécution de l’IA : pourquoi la majorité des entreprises peinent encore à produire des résultats

L’écart d’exécution de l’IA : pourquoi la majorité des entreprises peinent encore à produire des résultats

-

Compliance : Altares lance la première IA dédiée au traitement des faux positifs

Compliance : Altares lance la première IA dédiée au traitement des faux positifs

-

Impossible de stopper le shadow AI : voici comment en faire une force

Impossible de stopper le shadow AI : voici comment en faire une force

-

Seules 7 % des entreprises considèrent que leurs données sont entièrement prêtes pour l’IA, selon une nouvelle enquête menée par Cloudera et Harvard Business Review Analytic Services

Seules 7 % des entreprises considèrent que leurs données sont entièrement prêtes pour l’IA, selon une nouvelle enquête menée par Cloudera et Harvard Business Review Analytic Services

-

Denodo Platform 9.4 accélère la transition vers une IA agentique opérationnelle et performante

Denodo Platform 9.4 accélère la transition vers une IA agentique opérationnelle et performante

-

Sauvegarder, c’est gouverner : la donnée au cœur de la résilience numérique

Sauvegarder, c’est gouverner : la donnée au cœur de la résilience numérique

-

La moitié des entreprises françaises s’efforcent de développer des capacités IA agentiques fiables, mais le talent, le coût et la réglementation/l’éthique restent des obstacles

La moitié des entreprises françaises s’efforcent de développer des capacités IA agentiques fiables, mais le talent, le coût et la réglementation/l’éthique restent des obstacles

-

Pourquoi ne devrait-on plus avoir peur de l’optimisation mathématique ?

Pourquoi ne devrait-on plus avoir peur de l’optimisation mathématique ?

-

Des silos de données à la clarté décisionnelle : Workiva réinvente la GRC avec une plateforme dopée à l'IA pour l'audit, le risque et le contrôle

Des silos de données à la clarté décisionnelle : Workiva réinvente la GRC avec une plateforme dopée à l'IA pour l'audit, le risque et le contrôle

-

De l’avenir de Teradata...

De l’avenir de Teradata...

À propos

Claude-Olivier Fontaine est un consultant en systèmes d'information décisionnels spécialisé dans la mise en œuvre de solutions de reporting et l'accompagnement en gestion de projets.

Archives

Dernières notes

Certifié en gestion de projets avec Prince2

07/12/2011

Certifié sur la plateforme ETL Talend

12/04/2011

Mes publications

02/04/2011

Le marché des plateformes décisionnelles

07/02/2010

Mon Agenda pour les TechDays 2010

13/01/2010